この記事の3行要約

- AIエージェントの定義・構造・活用事例を、初心者にもわかりやすく体系的に解説

- 人間の「指示」から「共創」へと進化する今、AIとの関係性も“道具”から“仲間”へと変わり始めている

- 本記事では、エージェント型AIの基本要素から導入の注意点まで、実践に役立つ情報を網羅しています

こんにちは、リュウセイです。

ChatGPT活用支援サービスをやっています。

今回は「AIエージェント」のテーマで記事を書いていきます。

僕も正直、この“AIエージェント”という言葉を聞いたときは「ただの自動化ツールかな?」程度に考えていました。

でも調べていくうちに、その多種多様な概念と広がりに魅了されたんですよね!

そもそもAIエージェントというのは、ただのプログラムではなく、「目的を達成するために自律的に動くAIプログラム」という点がポイントです。

いったい何がそんなにすごいのか? どうやって会話して、どうやって学習し、どうやって実行するのか?

初めて聞く人にとっては「そもそもAIって何から学べばいいの?」というところから大きな壁を感じると思います。

この記事では、AIエージェントに関する基本的な知識から、大規模言語モデル(LLM)とのつながり、そして初心者でも分かりやすい活用事例までを、とにかく超具体的に解説していきます!

たとえば「Prompt Engineering」や「Chain-of-Thought」といった用語も同時に登場しますが、無理なく理解できるように説明していきますのでご安心くださいね。

また、Reinforcement Learning(強化学習)やSelf-Healing Agents(自己修復エージェント)といったちょっと先進的な話題にも触れるつもり。

最終的には、「あなた自身がAIエージェントをどう作り、どう活用し、どう未来を切り開いていくか」という視点を獲得できるよう、読みやすく丁寧に書きました。

それでは早速、本題に入りましょう!

当記事は、筆者の下書きとChatGPTを合わせて執筆しています。しっかりファクトチェック済みです。

AIエージェントとは?まずは基本を理解しよう

ここからは本格的にAIエージェントの解説をスタートします。

初心者にとって最初のハードルは、「AIエージェントって何?何ができるの?」という疑問ですよね。

「エージェント」という響きだけだと、まるでスパイ映画の主人公のような印象がありますが、AIの世界におけるエージェントとはどんな役割を果たすのか、じっくり解説していきます!

AIエージェントの定義と特長

ここでは基礎から具体例まで超丁寧に書いていきます。

AIエージェントという言葉は、学術的には「ある環境と相互作用しながら、自律的に行動し、目的の達成を図るシステム」と定義されています。

たとえば人間が行うようなタスクを、プログラム自身が判断しながら実行するところがポイント。

イメージしやすい例として、対話型エージェントを挙げてみましょう。

音声アシスタント(AlexaやSiriなど)を想像すると分かりやすいかもしれません。

あれはユーザーからの音声入力を受け、天気を教えたり、ニュースを読み上げたり、音楽をかけたりしますよね。

実はあれも立派なAIエージェントの一種なんです。

ユーザーのリクエストという環境からの入力を受け取り、それに対して自律的に行動を決定し、結果(音声出力)を返すという流れを持っています。

ただし、一般的な音声アシスタントがAIエージェントかどうかという議論は、学界でも少し複雑です。

なぜなら、多くの音声アシスタントは背後にあるAIがクラウド上にあって、シンプルな命令に対して特定の行動をしているだけ、という構造になりやすいから。

一方、より高度なAIエージェントは、「自分で目的を再定義しながら行動を変えていく」という自律性が強みなんですね。

たとえば、近年話題となっているSelf-Healing Agents(自己修復エージェント)は、エラーや問題に直面したときに、そのエラーを自律的に分析して修復し、再実行できるような仕組みを備えています。

これによって、単に応答を返すだけでなく、自分の行動ロジックを検証・改善し続けるという凄まじい学習能力を手に入れるわけです。

さらに、Agent-Based Simulation(エージェントベースシミュレーション)という分野では、仮想空間の中に多数のAIエージェントを配置し、各エージェントが互いに影響を与え合いながら動的に変化していく様子をシミュレートします。

これによって、複雑な経済システムや社会現象を分析したり、最適な政策を考えたりすることが可能になってきています。

実際の現場でも、たとえば工場の最適化などの業務にエージェントを導入し、複数のマシン同士が連携して生産工程を効率化するイメージが進んでいます。

製造ラインにおける製品の順序やタイミングを、一つひとつ人が調整するのは大変ですよね?

それをAIエージェントに任せると、停止時間を最小化したり、在庫のロスを抑えたりと、コストダウンに直結するメリットが生まれています。

ここで強調したいのは、AIエージェントの特長は「自律性」と「環境への適応」にあるということ。

プログラムに書かれた固定の手順をただ実行するだけではなく、状況の変化に合わせて行動を更新していく柔軟さこそが、AIエージェントの真骨頂なんです!

よくある活用事例と初心者にありがちな疑問

さて、AIエージェントの定義や特長は分かったものの、「実際にはどんなところで使われているの?」という疑問があると思います。

ここでは初心者がつまづきやすいポイントや、よくある事例を交えながら理解を深めていきましょう。

AIエージェントの主な活用事例

- カスタマーサポートチャットボット

- Webサイトのサポートページで見かける自動応答のチャットボット。

- これはユーザーからの問い合わせ(環境入力)に応じて、適切なFAQページや回答を返す。

- ただし、高度なシステムでは会話の意図を深掘りし、解決策を提示するだけでなく、その後のフォローアップを行う機能もあったりする。

- 金融トレーディング・アドバイザー

- 株やFXの取引を自動化するシステム。

- 相場データ(環境入力)を分析し、利益を最大化するためのポジションを取ったり決済を行う。

- 近年はReinforcement Learningを使って、過去の成功パターンを学習し、より賢く取引を行うAIエージェントが登場している。

- ゲームAI

- 多くのゲームで採用されている、敵キャラや味方キャラの自動行動システム。

- たとえば、リアルタイムストラテジーゲームの敵AIは、プレイヤーの動きを観察しながら部隊配置を変更したり、攻め方を工夫したりする。

- これもAIエージェントの一種で、環境を認識して自律的に行動するという基本原理は同じ。

- パーソナルアシスタント(個人秘書AI)

- ユーザーのスケジュール管理やタスク管理、メール返信などを自動化。

- 近年はカレンダーやメールの文脈を理解し、「この時間は会議を入れない方がいい」「この案件は締め切りが迫っているから優先度を上げよう」といった助言までできるようになってきている。

初心者にありがちな疑問

- Q. AIエージェントとロボットは違うの?

- ロボットは物理的なハードウェアを持ち、動いたり作業したりする機械装置を指すのが一般的です。

AIエージェントはあくまでソフトウェア的な概念で、場合によってはロボットに組み込まれることもありますが、本質的には「目的達成のために思考・判断するシステム」として捉えられます。

- ロボットは物理的なハードウェアを持ち、動いたり作業したりする機械装置を指すのが一般的です。

- Q. AIエージェントを作るのに何が必要?

- 基本的には大規模言語モデル(LLM)などのAIモデルを活用するケースが多いです。

それに加えて、学習データや実行環境、場合によっては強化学習の仕組みなども必要になるでしょう。

ただし初心者向けに提供されているクラウドサービスもあるので、いきなり自力で全部作る必要はありません!

- 基本的には大規模言語モデル(LLM)などのAIモデルを活用するケースが多いです。

- Q. 自律的に行動するなんて、ちょっと危険じゃない?

- もちろん、行き過ぎた自律性にはリスクが伴います。

そのためMLOps(機械学習運用)やガバナンスの仕組みを整え、安全にAIを管理する必要があります。

自動化できる部分と、人間がチェックすべき部分をきちんと線引きすることが大切ですね。

- もちろん、行き過ぎた自律性にはリスクが伴います。

大規模言語モデル(LLM)とのつながり

ここからは、AIエージェントを語るうえで欠かせない存在である「大規模言語モデル(LLM)」との関係性について、さらに深く掘り下げていきます!

Prompt EngineeringとChain-of-Thoughtの基礎

ここではLLMがなぜAIエージェントの基盤技術となり得るのかを詳しく解説します。

そもそも「大規模言語モデル(LLM)」とは何かというと、膨大なテキストデータから言語パターンを学習したAIモデルのことです。

GPT系モデルやBERT系モデルなどが有名ですよね。

これらはインターネット上の多種多様な文章を学習し、「文脈に応じた適切な応答」を生成できる点が強みです。

AIエージェントの文脈でLLMが大活躍するのは、「人間の言語を理解し、それを処理・生成する能力」が必要不可欠だから。

たとえば、「ユーザーが望むタスクは何か?」「今の状況における最適な行動は何か?」などを推論する上で、人間の意図を正確に理解できるモデルが有利なのです。

ここでPrompt Engineeringという概念が登場します。

AIモデルに対して「どんな指示(プロンプト)を与えるか」をデザインする行為で、Chain-of-Thought(思考の連鎖)と呼ばれるプロンプトテクニックを活用すると、LLMの推論がさらに高度になります。

Chain-of-Thoughtとは何か?

簡単に言えば「モデルに対して、推論や思考の過程を意図的に促すプロンプトを与えること」です。

通常のAIモデルは一気に回答を生成しますが、Chain-of-Thoughtを利用すると、「中間的なステップ(思考プロセス)」をモデルに展開させることができ、より正確で複雑な課題解決が可能になるケースが多いんです。

具体的な例を挙げると、たとえば数学の文章問題に対して、「問題文を分解して論理的ステップを踏みながら解答を導いて」というプロンプトを与えるとします。

その結果、モデルは頭の中の“考え”をテキスト上で逐次的に描写しながら解答を導いてくれるわけですね。

これがChain-of-Thoughtのわかりやすい事例です。

AIエージェントでは、このような「推論を段階的に実行する仕組み」がタスクの成功率を大きく左右します。

たとえば複数のサブタスクに分割して順番に実行したり、エラーが出たら原因を自己分析して修正したりするプロセスをChain-of-Thoughtと相性よく組み合わせれば、より高度な自律的行動が期待できるわけですね。

Zero-Shot Reasoningを使った高度な推論

次に「Zero-Shot Reasoning」を取り上げましょう。

これは、「例示なしでタスクや質問に答えられる能力」を指します。

普通のAIモデルは、似たような例を学習した上で、そのパターンを参考に回答を生成することが多いのですが、Zero-Shot Reasoningの場合、過去の学習例と全く似ていない問いにも、それなりに正解に近い回答を導ける可能性を持っています。

具体的なシチュエーションで考えてみましょう。

もしあなたが「未知の単語」や「未知の概念」について急に質問をされたら、普通なら「わからない」と答えるか、誤った推測をしてしまうかもしれませんよね。

しかしLLMの中には、言語的文脈や統計的知識を総合的に活用し、その未知の概念を既知の知識と関連付けながら、理にかなった推論を行うケースがあります。

例として「MCP(Model Context Protocol)」という用語をゼロショットで説明させるとしましょう。

LLMがそれまでMCPの正式な定義を見たことがなかったとしても、「Model」「Context」「Protocol」という単語の組み合わせから何らかの推測を行い、「モデルの文脈に関するプロトコル=学習・推論で使われる文脈情報を標準化する手順かもしれない」などと推論することがあり得るのです。

こうした予測推論をうまく活用すると、初めて触れるタスクでもAIエージェントが柔軟に対処できる可能性が高まります。

このZero-Shot Reasoningが応用されると、未知のシチュエーションへの適応力が飛躍的に向上します。

AIエージェントが自律的に活動する際に、必ずしもすべてのパターンを事前に人間がプログラミングしておく必要がなくなるわけですね。

つまり、トラブルシューティングや予期せぬ問い合わせにも対応できる確率が上がり、より“賢い”エージェントへと進化していくことになるでしょう。

Reinforcement Learningで広がる可能性

続いては、AIエージェントを更に“自律的”にするための肝となる技術、「Reinforcement Learning(強化学習)」の世界に踏み込みます!

RLHF(人間のフィードバックによる強化学習)の導入

ここからはより高度な内容を扱いますが、初心者にも直感的にイメージしやすいように分かりやすく解説しますね。

強化学習とは、「エージェントが環境から報酬(Reward)を得られるように学習し、行動方針(Policy)を最適化する」ことを目的とする機械学習手法です。

例を挙げると、あるゲームにAIエージェントを参加させて「勝ったら+1点、負けたら−1点」などの報酬を設定すると、AIはトライ&エラーを繰り返しながら、得点を最大化する戦略を習得していきます。

これはまさに「試行錯誤しながら成長していく人間の学習」に近いプロセスなんですよね。

たとえば碁や将棋、チェスなどでAlphaGoやAlphaZeroが頂点を極めたのも強化学習の賜物。

ゲームだけでなく、ロボティクスや最適化問題、経営戦略シミュレーションなど、さまざまな分野で活躍が期待されています。

さて、最近話題のRLHF(Reinforcement Learning from Human Feedback)というのは、「単純な数値報酬だけでなく、人間からのフィードバックを学習プロセスに組み込む」というアプローチです。

具体的には、AIのアウトプットに対して人間が「良い」「悪い」「ここを修正すべき」などのラベルを付与し、それを報酬とみなして強化学習を行うわけです。

例えば、チャットボットの応答品質を高めるために、人間が「この応答は正確であり、読みやすく、ユーザーフレンドリーである」と評価したら+1点、逆に「誤解を招く表現でユーザーに不快感を与える」と評価したら−1点、といった具合に学習させます。

こうすると、人間の価値観をより強く反映したAIエージェントを育てることができるため、実用的なシナリオでのAI活用が一気に加速するんですね。

超具体的な現場イメージ

- カスタマーセンターのチャット対応

- ユーザーの質問にAIが答える。

- サポート担当者(人間)が、その回答が適切かどうかを評価し、補足や訂正を行う。

- その評価がAIエージェントの報酬としてフィードバックされる。

- AIは「どんな回答だと高評価が得られ、どんな回答だと低評価になるか」を学習する。

- オンライン教育ツール

- 学習者が問題を解いたり質問を投げたりする。

- AI教師役(エージェント)が解説を行う。

- もし分かりにくい解説や誤回答があれば、受講者や人間の講師がフィードバックを付与。

- それを元に次回以降の解説のクオリティを自動的に高める。

このように、RLHFをうまく取り入れることで、AIエージェントがユーザーにとって使いやすく、信頼できる存在へと進化していく可能性が広がっているんです。

Self-Healing Agentsを支える強化学習の仕組み

次に挙げたいのが「Self-Healing Agents(自己修復エージェント)」という概念。

名前からしてSF映画に登場しそうですが、実際にはプログラムが自己監視機能を持ち、バグやエラーに遭遇した際に自動修復を試みるという発想です。

これにも強化学習が深く関わっています。

エージェントがバグを検出したときに、「どう対処すればシステムが復旧し、再発を防げるか?」を試行錯誤しながら学ぶわけですね。

つまり、エラーを解消できた場合に正の報酬を、エラーが解消されなかった場合や別の新たなエラーを生んだ場合に負の報酬を与えるイメージ。

例えば、クラウド環境でサービスを運用していて、突然特定のAPIが応答しなくなったとします。

普通ならエンジニアがログを追いかけて原因を特定し、手動で再起動や設定変更などを行いますよね。

しかしSelf-Healing Agentが導入されていれば、「ログを分析 → 予測原因を抽出 → 該当サービスの再起動やリソース割当変更を実行 → 成功すれば学習」というフローを自動化できる可能性があるんです。

実はこれ、運用コストの削減にも大きく貢献します。

24時間365日、常に人間がシステムを監視する必要がなくなり、エージェントが問題を検知・修復する度に学習を続けるため、長期的には安定稼働の精度が高まるというメリットが見込めます。

現場感あふれる具体的シナリオ

- クラウドインフラの障害対応

- 何かの原因でトラフィックが急増し、レスポンスが極端に遅くなる。

- エージェントがその兆候をモニタリングでキャッチし、リソースを自動でスケールアウト。

- もしスケールアウトで対処できなければ、別のデータセンターへトラフィックを振り分けるなどの施策を試す。

- 成功したら「このパターンではスケールアウトが有効」として記録、失敗したら別の手を試す…の繰り返し。

- ソフトウェアアップデート後の検証プロセス

- 新しいコードをデプロイするたびに、エージェントがテストスクリプトを実行。

- もし特定のテストでエラーが発生したら、ログを解析して原因箇所を推定。

- 該当モジュールだけをロールバックしてみたり、関連する設定を変更して再テストしたりを自動で試行。

- 「どんな変更がエラー解消につながったのか」を学習し、次のアップデートで活かす。

こうした仕組みは一朝一夕で実装できるものではありませんが、強化学習と組み合わせることで継続的な自己改良が可能になるのは間違いありません!

Model Context Protocol(MCP)やRAGを理解する

ここからは、AIエージェントを理解するうえでぜひ知っておきたいModel Context Protocol(MCP)とRetrieval Augmented Generation(RAG)について深堀りしていきます。

MCPという用語はあまり耳慣れないかもしれませんが、AIの推論プロセスにおけるコンテキスト管理を標準化・効率化する仕組みとして注目を集めつつあります。

一方、RAGはLLMや機械学習モデルなどと相性が良く、データの検索・参照を組み合わせた高度な応答生成が可能。

「巨大モデルに何でも任せればいい!」という時代は終わりつつあり、適切な文脈(Context)を与え、必要な情報を上手に取り出すことが、より賢いAIエージェントを作る上での鍵となってきているんです。

Context Windowの上手な活用方法

AIエージェントが文脈を正しく理解するために重要なのが、Context Windowという考え方。

これは、LLMが一度に取り扱えるテキスト入力の範囲や長さを指す用語です。

たとえばGPT系モデルの場合、数千トークン(単語や記号などを含む単位)を一度に処理できますが、そのキャパシティを超えると文脈が途切れやすくなるという問題があります。

実はこのContext Windowを意識した設計こそが、実践的なAIエージェント運用で非常に大切。

理由としては、以下のようなポイントが挙げられます。

- タスクの分割と連携

- 大きなタスクを複数の小さなタスクに分解する際、各サブタスクで必要となる情報(コンテキスト)が何かを明確にする必要がある。

- たとえば「ユーザーが入力した文章を要約する」→「要約結果を元に別の推論を行う」→「最終的な応答を生成する」といった流れを段階的に組むときに、どの段階でどの情報を保持し、どれを破棄するかを考えるのがポイント。

- Token制限との戦い

- 大規模言語モデルは、その性能を最大限に引き出すために十分な文脈が必要ですが、一度に扱えるトークン数には上限がある。

- 重要情報だけを抽出して再入力する技術が欠かせない。

- ここで活きるのがMeta-Learning的な発想で、「エージェント自身が必要な文脈だけをうまく要約する」仕組みを組み込むと、より柔軟なタスク処理が期待できる。

- 会話履歴を管理する

- 対話型エージェントで長いやり取りを続けると、ユーザーとの過去のやりとりをすべて含めてコンテキストに入れなければ、一貫性ある回答が難しくなるケースがある。

- そのため過去の会話履歴を要約し、要点だけを保持するというテクニックが重要になる。

ここでModel Context Protocol(MCP)が出てくるわけですね。

MCPでは、エージェントが必要とする文脈情報(ユーザープロファイル、過去の対話ログ、タスクの進捗など)をどのようにやり取りするのかを標準化し、APIレベルで整理する狙いがあります。

つまり、「コンテキストを扱う方法」をルール化することで、複数のエージェントやシステムが協調しやすくなるわけです。

MCPを活用するメリット

- エージェント間の相互互換性が高まる

- 共通のプロトコルに従うことで、複数のエージェント同士が文脈情報を交換しやすくなる。

- たとえば、A社が開発した対話エージェントとB社のデータ分析エージェントが連携し、ユーザーのリクエストをスムーズに処理できる。

- 開発効率の向上

- MCPを意識して開発すれば、「文脈管理をどこで何を使って行うか」という仕様が明確になる。

- いちいち独自の方式を考えなくて済むので、新たなエージェントを追加したり既存システムと連携したりするハードルが下がる。

- 複雑なタスクの段階的処理が容易

- タスクをフェーズごとに区切り、必要に応じて文脈情報を切り替えるだけでなく、どの時点でどの情報を共有するかを制御しやすい。

一方、MCPに対しては「実際にどこまで標準化できるのか」という議論もありますが、AIエージェントが多種多様な業務をこなす未来を見据えると、こうした共通言語やプロトコルはますます重要になっていくでしょう。

Retrieval Augmented Generation(RAG)の実例

RAGは、LLMが回答を生成する際に外部のデータソースを活用する仕組みです。

通常、LLMは事前学習済みのパラメータを使って文章を生成しますが、学習に使われなかった新しい知識については正確な回答ができないリスクがあります。

そこで「検索(Retrieval)」の工程を間に挟み、ユーザーの質問に関連する情報を外部から取り込んで回答を補強するわけですね。

具体的な流れのイメージ

- ユーザーが質問を投げる

- たとえば「最新のiPhoneシリーズとAndroid端末を比較した際のバッテリー寿命は?」という質問を入力するとしましょう。

- 検索エンジンやドキュメントを参照

- エージェントはまずRAGの仕組みに従い、外部の知識ベースやインターネット検索を行って「該当機種のバッテリー評価」など、最新情報を収集する。

- Embeddings(単語埋め込み)を活用することで、テキストの意味的な類似度検索が行われ、必要な情報を的確に見つける。

- LLMに情報を入力し、回答を生成

- 収集されたデータをLLMに再度プロンプトとして与え、Chain-of-Thought方式などを使いながら回答を組み立てる。

- 「iPhone 14のバッテリー容量は〇〇mAh、Android端末の平均バッテリー容量は〜」といった具体的な数字も含め、詳しく比較できる。

- ユーザーに最終的な応答を返す

- 回答には、外部から取得した引用元や参考データを含められるため、根拠の明確化や情報の最新性が確保しやすい。

このようにRAGを使うと、LLM単体では取得できない生の知識や最新情報を回答に反映できるのが強みです。

特にニュースやトレンドが激しく変動する領域では、LLMの事前学習時期と実世界の情報のギャップを埋める救世主的存在と言えるでしょう。

RAGがもたらすメリット

- 常に最新の情報を取り込める

- AIエージェントが適宜外部リソースを参照してアップデートされた情報を取得できるため、「モデルが古い知識しか知らない」問題をある程度緩和できる。

- 回答の信頼性向上

- 引用元URLなどをユーザーに提示できるため、「どこからその知識を得たのか」を示せる。

- これによってエビデンスベースの回答が可能になり、利用者の安心感が増す。

- 分野特化のエージェント開発が容易

- たとえば法律や医療、金融などの専門分野で、巨大モデルに全部を覚えさせるのは大変。

- そこで分野特化データベースをRAG経由で参照すれば、LLMのパラメータを再学習せずとも、専門的かつ正確な回答を導きやすい。

もちろん、RAGの導入には検索やデータベースとの連携が必要になるため、システム設計はやや複雑になります。

また、外部データの信頼性やセキュリティの確保も課題の一つ。

それでも、多角的な情報を扱うAIエージェントを実現する上で、RAGは今後の主流技術として大いに期待されています。

注目のAIエージェント事例

ここでは、いま話題のAIエージェント事例をどどんと紹介します!

実際に名前を聞いたことがある方もいると思いますが、Auto-GPTやBabyAGIといったプロジェクトは、近年AI界隈を賑わしている代表例。

そこに加えて、Persona-based AgentsやGoal-Oriented Dialogueなど、多様なアプローチのエージェントが次々と登場しています。

最先端の実例を知ることで、「あ、こんなことまでできるんだ!」というインスピレーションを得てほしいと思います。

Auto-GPTとBabyAGIの特徴

まずは、Auto-GPT。

これは、LLM(例:GPT-4など)に対して、「ゴール」を与えるだけで、自動的にサブタスクを生成・実行し、結果を再評価して次の行動を決めるというアプリケーションです。

たとえば「ブログ記事を作成し、SNSで共有して、さらに読者の反応を収集しレポートを作成して」という一連のタスクを与えると、Auto-GPTはそれを細分化しながら実際に作業を進めようとします。

Auto-GPTの画期的ポイント

- 連続的な思考と行動

- 通常のGPT系モデルは1回の入力・出力で完結しますが、Auto-GPTは次の行動を考えて実行する流れを自動化している。

- これはまさに「エージェントが計画を立て、試行し、検証し、次の行動を決める」というフローそのもの。

- インターネットへのアクセス

- バージョンによってはWeb検索を行い、外部サイトから情報を取得したり、別のAPIを呼び出したりして、より高度なタスクを処理可能。

- たとえば「旅行プランを提案して」と指示すると、最新の航空券やホテル情報を検索して提案してくれる。

- 自己評価・自己修正

- たとえば、途中でエラーが発生すると、それを検知して別のアプローチを試すなど、自己修復の萌芽が見られる。

- 完全なSelf-Healing Agentsにはまだ届かない部分があるが、発展の方向性として大いに期待できる。

一方で、Auto-GPTはまだ実験的な要素が強く、複雑なタスクではエラーや意図しない挙動も少なくありません。

しかし「ユーザーが最小限のプロンプトを与えるだけで、AIエージェントが連続動作する」コンセプトは衝撃的で、SNSやコミュニティで一気に広まりました。

続いては、BabyAGI。

こちらも基本的な考え方はAuto-GPTと似ていて、「目標指向」かつ「再帰的」にタスクを生成・実行することを狙ったプロジェクトです。

名前にある通り「AGI(汎用人工知能)の赤ちゃん」をイメージしており、タスク管理と学習をシンプルな仕組みで試みています。

BabyAGIの注目点

- シンプルなアーキテクチャ

- タスク一覧を保持するキューと、LLMを呼び出すロジックが中心になっていて、理解しやすい構成。

- Pythonで少ない行数で実装できるため、AI開発初心者でも手を動かしながら学びやすい。

- 連続タスク生成

- タスクを1つ終わらせたら、その結果に応じて「次にやるべきこと」を自動で追加する。

- 例えば「新商品のマーケ戦略を立案して」という要望に対して、市場調査→競合分析→広告文面の案出し→SNSキャンペーン実施…と芋づる式にタスクが派生。

- 自己改善ループ

- 作業が失敗すると、それを踏まえた新たなタスクを生成し、再挑戦する仕組み。

- 人間が逐一指示しなくても、「うまくいかなかった理由」を仮説立てて再試行する様子は、まさに強化学習的な動きに近いといえる。

BabyAGIもAuto-GPT同様、まだ完全無欠とは言えません。

しかし、こうした“自律稼働”を目指すフレームワークがオープンソースとして公開された意義はとても大きいと感じます。

「エージェントが自分で考え、行動し、学習する」という理想を少しずつ現実に引き寄せているわけですね。

Persona-based AgentsとGoal-Oriented Dialogue

AIエージェントが人間との対話において、より高い説得力や親しみやすさを実現する方法として、Persona-based AgentsやGoal-Oriented Dialogueの概念が注目されています。

Persona-based Agentsとは?

- Persona(人格・キャラクター設定)をAIエージェントに付与する手法。

- ユーザーが対話する際、AIの発言内容やトーン、語彙選択などが一貫したキャラクターに基づいて行われるので、より自然で魅力的なコミュニケーションを体験できる。

- 例えば「ビジネスコンサルタント風エージェント」として振る舞う場合、敬語を多用しつつ、論理的な提案やデータを重視する回答をするよう設計。

- 一方で「友達感覚のラフなエージェント」にするなら、カジュアルな言葉遣いやエモーショナルな反応を返すように調整できる。

Persona-based Agentsは、カスタマーサポートや教育システムなど幅広い用途で活躍が期待されています。

「ロボットと話している感」を薄め、人間らしさを演出したいシーンに適しているんですね。

Goal-Oriented Dialogueとは?

- 文字通り、「特定のゴール達成を目的にした会話」を意味する。

- たとえば、レストランの予約をしたいユーザーのために、予約完了までをスムーズにガイドするエージェントがこれにあたる。

- 会話の途中で雑談や横道に逸れることなく、最終的なゴール(例:予約情報の確定)に向かってステップを案内するように設計されている。

Goal-Oriented Dialogueは、特定業務に特化したチャットボットで使われることが多いです。

タスク達成率やユーザー満足度を高めるため、Persona-basedの要素と組み合わせることも多いですね。

例えば高級ホテルの予約システムなら、高級感を演出するPersonaを与えつつ、ゴール指向で情報をやり取りするように設計すると、利用者も自然に予約完了まで進めるというわけです。

Multi-Agent Systemsがもたらす協調効果

これまでは「単一のAIエージェント」がいかに自律的にタスクをこなすか、という視点が主流でしたが、複数のAIエージェントが連携し合うMulti-Agent Systems(マルチエージェントシステム)にも注目が集まっています。

マルチエージェントの利点

- タスク分散と専門性

- たとえば、対話に特化したエージェント、データ分析に強いエージェント、画像認識が得意なエージェントなど、それぞれの専門分野に特化したエージェント同士が連携し合うことで、総合力の高いシステムが実現。

- 人間で例えると、プロジェクトチームが複数の専門家で構成されているイメージに近い。

- 拡張性

- 新しいタスクが発生した場合でも、そのタスクに特化したエージェントを新たに追加するだけで対応できる。

- システム全体を大きく作り変える必要がないため、アジリティ(俊敏性)が高い開発体制に向いている。

- 冗長性と堅牢性

- もし1つのエージェントが故障したり性能低下を起こしたとしても、他のエージェントがカバーする形でシステムを運用できる。

- 大規模な障害を回避しやすく、Self-Healing Agents的な概念とも相性が良い。

具体例:製造ライン最適化

- 複数のロボットや機械を制御するエージェント

- 各マシンの状態(温度、稼働状況、在庫量など)をそれぞれの専用エージェントがモニタリング。

- それらの情報を集約する中央統括エージェントが生産計画を立てる。

- 計画に不備があれば、生産ラインの一部を停止させてメンテナンスエージェントに引き渡す、などの連携プレーを実行。

- 自動倉庫管理

- マルチエージェントによって、在庫管理エージェント、物流ルート最適化エージェント、需要予測エージェントが連携し、最適な在庫数や出荷タイミングを調整。

- 需要が急増したときは増産指令を出し、需要が落ち着いたら在庫を減らすようにロボットに指示する。

マルチエージェントシステムの考え方は、社会シミュレーションや交通制御、オンラインゲームなどでも広く採用されつつあります。

今後は、エージェント同士のコミュニケーションプロトコルや競合と協調をどう設計するかが焦点になってくるでしょう。

MLOpsとエージェント運用のポイント

ここからは、AIエージェントを実際にビジネスやサービス運用の現場で活かすために不可欠となる「MLOps(機械学習運用)」の観点を取り上げていきます。

AIエージェントは導入して終わりではなく、継続的な運用やモニタリング、アップデートがカギになる。

その際、単なるソフトウェア開発とはひと味違う「機械学習ならではの運用ノウハウ」を身につけることが重要です!

Fine-TuningとInstruction Tuningで性能を引き出す

大規模言語モデル(LLM)やその他のAIモデルを自分の業務やユースケースに最適化するために、よく用いられる手法が「Fine-Tuning(微調整)」です。

もう一つ注目されているのが「Instruction Tuning(命令に合わせた調整)」。

ここでは両者の違いや特徴を整理しながら、実運用で気をつけるべきポイントを掘り下げていきます。

Fine-Tuning(微調整)とは?

- 学習済みモデルに対して、自分の手元のデータを追加学習させる工程。

- 例えば、医療文書を分析したい場合、既存のLLMに対して大量の医療レポートや論文を追加学習させることで、医療文脈に特化した精度を高める。

- 大規模モデルの土台を使うため、ゼロからモデルを作るよりデータ量を少なく抑えられることがメリット。

Instruction Tuning(命令に合わせた調整)とは?

- ユーザーの指示(命令)に特化した応答ができるよう、モデルを調整する手法。

- 具体的には「ユーザーの“〜して”に対して、どんな形で応答するのか」を学習データ化し、モデルに最適化を施す。

- 例えばカスタマーサポートシナリオでは、「クレーム対応」「問い合わせ対応」「案内のみ」などの異なる命令形式をモデルに理解させ、ユーザーの意図を汲んで柔軟に返せる応答力を鍛えるわけです。

実運用でのポイント

- 過学習(オーバーフィッティング)に注意

- 特定ドメインに特化しすぎると、汎用的な質問に対して逆に回答性能が落ちる可能性がある。

- 本当に必要な範囲だけ微調整し、メインとなる幅広い言語能力は損なわないようにするバランス感覚が大切。

- 継続的な評価データの確保

- “Fine-Tuning”や“Instruction Tuning”を行う際は、運用中も定期的に評価データを更新していくのがベター。

- ユーザーの問い合わせ内容や、時間とともに変化するトレンドを反映しないと、モデルが古い知識のまま停止してしまう恐れがある。

- セキュリティやプライバシー問題への配慮

- 医療や金融など、機密データを扱う場合は、データの匿名化やプライバシールールの順守が必須。

- プロンプトや学習データに含まれる個人情報をどう扱うか、内部ポリシーを明確にしておこう。

- MLOpsツールとの連携

- モデル管理(バージョン管理)、継続的インテグレーション(CI/CD)、自動テストなど、ソフトウェア開発の運用ノウハウを機械学習にも適用することで、安全かつ効率的にモデルのアップデートを回せる。

- エージェントごとに異なるバージョンのモデルを運用するケースもあり得るため、モデルリポジトリなどを活用してしっかり管理しよう。

Agent-Oriented Programmingを活用した開発

「Agent-Oriented Programming(エージェント指向プログラミング)」は、従来のオブジェクト指向プログラミングよりも一歩進んだ形で、“エージェント”という主体をプログラム上の基本単位と捉える手法です。

エージェント同士がメッセージのやり取りやイベント駆動を通じて連携し合い、目標を達成する流れを直接的に表現できます。

Agent-Oriented Programmingのメリット

- 自然な抽象化

- エージェントが持つ「認知(知覚)」「目標」「行動」といった要素を、プログラム設計にそのまま落とし込める。

- 「誰が何を目的にしているか」がコードレベルでも明確になるため、仕様との齟齬が少なくなる。

- 分散システムとの相性が良い

- マルチエージェントシステムを構築しやすく、ネットワーク越しに複数のエージェントが動作するような大規模開発にも向いている。

- 各エージェントが独立したプロセスで動き、メッセージを交換する設計がしやすい。

- 動的なタスク再分配

- 新しい目標が生まれたり、既存の目標が変更になった場合でも、エージェントのやり取りルールを少し変えるだけで対応可能。

- 大きなシステム改修に頼らなくても、エージェント単位の差し替えでアップデートできる。

開発フレームワークやツール

- JADE(Java Agent DEvelopment Framework)

- 古くからあるマルチエージェント開発の定番フレームワーク。

- エージェント間通信プロトコルが整備されており、知的エージェントの基礎を学ぶのに適している。

- Pythonベースのフレームワーク

- 近年はPython環境でも、エージェント指向の開発をサポートするライブラリが増えている。

- Auto-GPTやBabyAGIなどのプロジェクトも、基本はPythonで実装されており、追加のエージェント機能をプラグイン的に組み込む手法が試されている。

- クラウドプラットフォーム

- AWSやAzure、GCPといった大手クラウドベンダーが、AIモデルのホスティングからサーバーレスでのイベント駆動まで、マルチエージェントシステムを動かすためのインフラを提供。

- たとえば「Lambda関数同士をイベントで呼び出し合う」構成を作り、エージェント同士の連携をクラウド上で管理する例もある。

運用時の注意点

- 通信コストとレイテンシ

- 分散型のエージェントシステムでは、メッセージのやり取りが多発する可能性がある。

- ネットワークやサーバーリソースへの負荷を見越した設計が必要。

- 障害対応

- どこか一部のエージェントがクラッシュした際、ほかのエージェントはどう振る舞うかを定義しておく。

- 障害発生時に無限ループやデッドロックにならないよう、Self-Healing Agents的な設計思想も併せて活用したい。

- デバッグの難易度

- 非同期メッセージのやり取りが複雑になると、動作を追うのが困難になる場合がある。

- ロギングや可視化ツールを整備し、エージェント同士のやり取りの履歴をしっかり残すことが大切。

こうしたエージェント指向のプログラミング手法を取り入れることで、より人間の思考プロセスに近いシステム設計が実現します。

そして、それをMLOpsの仕組みの中で継続的にアップデートできれば、AIエージェントが運用中にどんどん賢く、使いやすくなっていく未来が見えてくるはずです。

AIエージェントを高度化するテクニック

AIエージェントをさらに「深く」「高度に」活用するためのテクニックを見ていきましょう。

すでに名前が登場しているKnowledge GraphやMeta-Learningなどの概念を知っておくと、エージェントの推論精度や学習効率を飛躍的に高めるアイデアが浮かんできます。

Knowledge Graphで精度を高める

Knowledge Graph(ナレッジグラフ)は、エンティティ(物や人、場所など)とその関係をノードとエッジで表現するデータ構造です。

たとえば「Apple(企業)」「iPhone(製品)」「Tim Cook(CEO)」といったエンティティがあり、「Tim CookはAppleのCEOである」「AppleはiPhoneを製造している」という関係性をグラフとして表すイメージ。

なぜAIエージェントにナレッジグラフが必要なのか?

- 文脈理解の強化

- LLMだけでは、“Apple”という単語を文脈から推測して「企業か果物か」などを判断することが多い。

- しかし、ナレッジグラフを使えば、Apple社に関する情報(所在地、主要製品、業績など)を直接参照でき、より正確な文脈理解が可能になる。

- 関係性の推論

- グラフが示す関係から、「この人物はこの組織に所属しているから、別の関連情報もまとめて提示しよう」など、関連知識のリンクをエージェントが自律的にたどれる。

- 例えば「iPhoneの最新モデルって何?」と聞かれた際に、「Appleの製品情報ノード→iPhoneシリーズ→最新モデル→発売日と特徴」と連鎖的に情報を引き出すイメージ。

- 不確かな情報の補完

- もしユーザーの質問に曖昧な要素があっても、グラフ上で近いノードを検索し、「もしかしてこのエンティティのことを言っているのでは?」と提案できる。

- 曖昧検索や類似エンティティの探索機能は、エージェントの回答精度を底上げする。

実装例

- 企業内ナレッジ活用

- 例えば大手企業が膨大なドキュメントや社内wikiをナレッジグラフ化しておき、AIエージェントが「このプロジェクトはどの部署が担当? 過去の成果は?」などの質問に即答。

- 人間がいちいち検索をかけなくても、グラフ上のリンク情報を辿るだけで素早く回答が得られる。

- パーソナライズド学習サポート

- 教育系プラットフォームで、学習教材や生徒の理解度データをグラフ化。

- 「数学の因数分解が苦手な人には、前提となる“乗法公式”を復習させる」というように、エージェントが関連知識マップを参照して学習プランを提案する。

導入にはデータの整理やグラフDBの構築が必要となりますが、長期的には効率的な情報活用と高度な推論が可能になるため、エンタープライズ領域を中心に急速に普及しつつあります。

Meta-LearningとEmbeddingsの実用例

Meta-Learning(メタ学習)は、「学習の仕方を学習する」という考え方。

一方でEmbeddings(単語埋め込み)は、テキストやアイテムなどをベクトル空間にマッピングして類似度検索を行いやすくする手法。

これら2つの概念はAIエージェントの文脈でも非常に重要な役割を担います。

Meta-Learningの概要

- 通常の機械学習:ある特定のタスク(例:猫画像を判定)に対して大量データを使って学習。

- メタ学習:多数のタスクを横断的に学習し、「新しいタスクにも素早く適応する能力」を身につける。

- たとえば、Aという画像識別タスクとBという画像識別タスクは別物でも、そこに共通する“学習戦略”を学んでおけば、Cという新しい画像識別タスクに少ないデータでも対応できるようになる、というイメージ。

AIエージェントが未経験のタスクをいきなり与えられたとき、メタ学習の成果が生きると、短い学習時間や少量のデータで高いパフォーマンスを発揮してくれる可能性が上がるわけです。

Embeddingsの実用例

- ドキュメント検索

- テキストをベクトルに変換し、ユーザーのクエリも同じ空間でベクトル化して比較。

- 類似度が高い文書を素早く取得できるので、FAQシステムやナレッジ検索に最適。

- 推薦システム

- ショッピングサイトや動画サイトで、ユーザーの嗜好と商品・コンテンツをベクトル空間で照合し、近いベクトルにあるアイテムをおすすめする。

- AIエージェントが会話の文脈を解析して、似た好みのユーザーや商品群を推定することも可能。

- 言語の壁を超えた検索

- 英語と日本語など異なる言語間でも、Embeddings空間で統合すれば、言語を横断した意味検索ができる。

- 「日本語で質問しているのに、英語の文献から回答を見つける」なんてことも簡単に実現可能。

エージェントとの組み合わせ

- メタ学習 + Embeddings

- メタ学習によって「少ない事例でも素早く対応する能力」を培ったモデルが、Embeddingsを活用して新しいトピックの情報を見つけ出す。

- 例えば、まだ実績の少ないマイナージャンルの問い合わせにも、関連度の高いデータを自動的に検索・学習し、精度の高い回答を行う。

- 自己強化型の情報収集フロー

- エージェントが自分でEmbeddings検索を使って関連情報を取りに行き、回答に活用して、その結果をさらに学習材料に加える。

- これにより、RAG(Retrieval Augmented Generation)とも相性が良く、エージェントの知識が加速度的に拡張される可能性もある。

Agent-Based Simulationの活用メリット

AIエージェントを使って、仮想空間で大規模シミュレーションを行うという手法も近年注目を集めています。

Agent-Based Simulation(エージェントベースシミュレーション)とは、各エージェントが独立した意志決定ルールを持ち、集団としてどのようなマクロな振る舞いが現れるかを分析するアプローチのこと。

代表的な応用領域

- 社会経済シミュレーション

- 都市計画、交通渋滞予測、消費行動分析など、人々の行動をエージェントとしてモデル化。

- 例えば「新しい道路を建設すると、渋滞はどれくらい緩和するのか?」や「増税すると消費パターンはどう変わるか?」などをシミュレートできる。

- 生態系シミュレーション

- 動物や植物、環境要因をエージェントとしてモデル化し、捕食・被食の関係や気候変動の影響を観察。

- 生態学の研究や自然保護計画に活用され、「この地域で外来種を駆除したらどのように生態系が回復するか」などを予測可能。

- 組織設計や人的資源管理

- 大企業内での組織構造やチーム連携をシミュレートし、新しいプロジェクト体制や評価システムを導入すると、従業員同士がどのようにコラボレーションするかを試験する。

- 実際の組織再編前に何通りものシナリオを試し、人的コストやリスクを最小化できる。

AIエージェントの導入効果

- より現実的なエージェント挙動

- 従来のシミュレーションは、単純なルールベースでエージェントの振る舞いを定義することが多かった。

- しかしLLMや強化学習を搭載したAIエージェントなら、複雑な判断ロジックや適応学習が可能になり、シミュレーション結果が現実に近づく。

- 政策や戦略の事前検証

- 社会実験や大掛かりな施策を実際に試すのはリスクが高い。

- AIエージェントを使ったシミュレーションなら、多数の仮説やシナリオを素早く評価でき、意外な副作用やボトルネックを事前に発見できるかもしれない。

- 人間とのハイブリッド分析

- シミュレーション結果を人間の専門家が評価し、さらに修正指示を与えると、AIエージェントが修正後のシナリオを自動実行→再度分析、というフィードバックループが回せる。

- 政策決定や経営判断のサポートツールとして、より賢い結論を導くサイクルが形成される。

Agent-Based Simulationは本来、プログラム的にルールを定義して動かすものでしたが、今後はAIによるリアルタイム学習が組み合わされることで、「シミュレートしながら学習し、学習しながらシミュレートする」新しい研究・実務手法へと発展していく可能性が大いにあります。

実装に向けたステップバイステップ解説

ここからは、実際にAIエージェントを自分のプロジェクトに導入するうえで、どのように進めれば良いのかをステップバイステップで解説していきます。

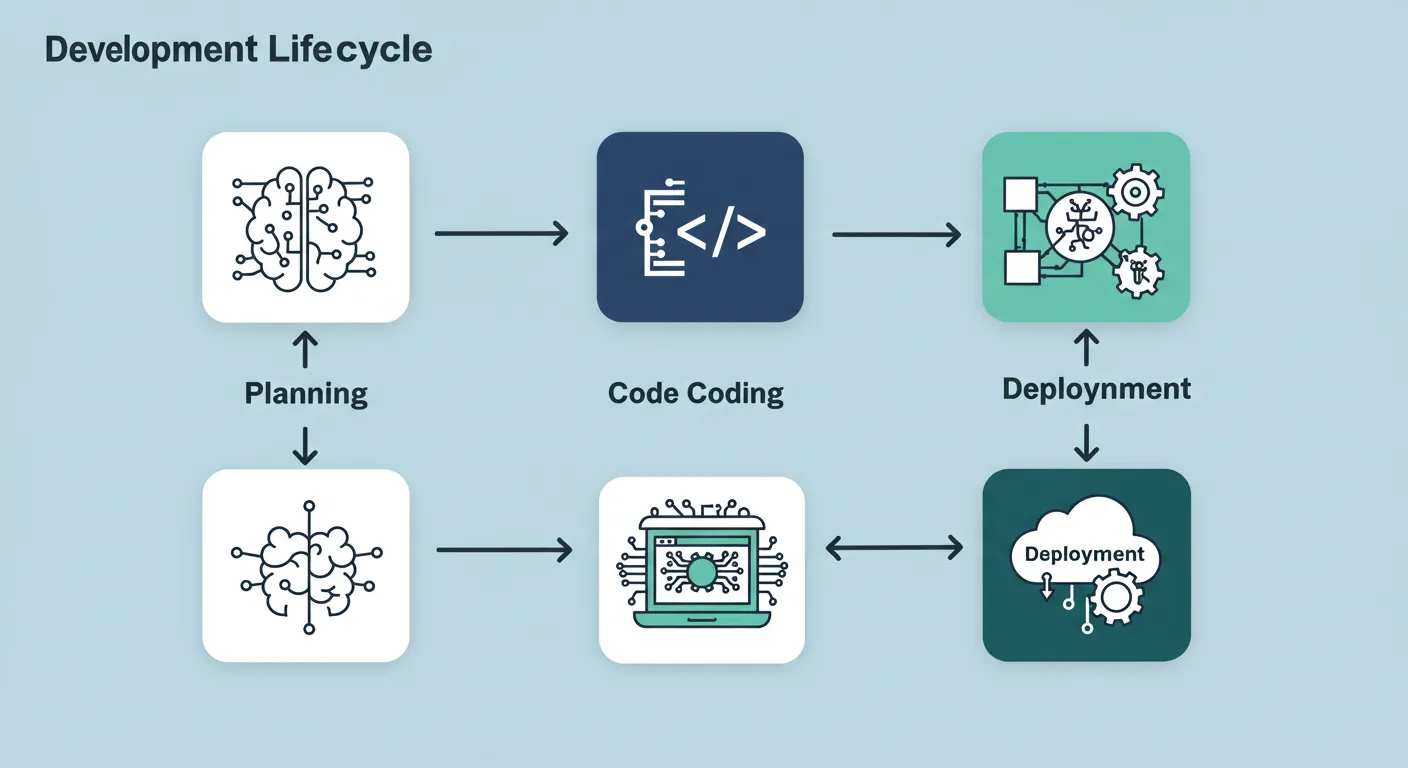

エージェント開発の流れは、ざっくり言うと

- プロジェクト目的の定義・要件整理

- 開発環境やライブラリの選定

- 設計・実装

- テスト運用と改善

- 本番運用と継続的アップデート

という段階的プロセスに分けられることが多いですね。

以下で詳しく説明するので、ぜひ参考にしてみてください!

開発環境とライブラリの選定

「最初に何を用意すればいいかわからない…」という人は少なくありません。

AIエージェントに関しては、用途によって必要な環境が変わりますが、大まかな選定基準を以下にまとめました。

1. プログラミング言語

- Python

- AIや機械学習の豊富なライブラリ(PyTorch、TensorFlow、Hugging Face Transformersなど)が充実。

- Auto-GPTやBabyAGIもPythonで書かれており、コミュニティの盛り上がりも抜群!

- 学習コストも比較的低いので、初心者でも導入しやすい。

- Java

- 大規模システム開発やエンタープライズ領域で根強い人気。

- Agent-Oriented Programming向けのフレームワーク(JADEなど)を活用すると、複雑なマルチエージェント環境の構築がスムーズ。

- ただし、機械学習関連の最新ライブラリはPythonが先行しがちなので、Java環境だけで完結させるには工夫が必要。

- その他(C++、Go、Rustなど)

- パフォーマンス重視のロボティクスやネイティブアプリケーションで用いるケースも。

- ただし機械学習のライブラリ面ではPythonが圧倒的なため、C++とPythonを組み合わせるハイブリッド開発などが現実的。

2. AIフレームワーク / ライブラリ

- PyTorch / TensorFlow

- ディープラーニングモデルを扱う代表格。

- 学習済みモデルを微調整(Fine-Tuning)するときや、独自モデルを構築したいときに必須。

- 大手企業やコミュニティがバックアップしており、ドキュメントも豊富。

- Hugging Face Transformers

- 大規模言語モデル(LLM)のロード・推論が手軽に行える。

- GPT-2やGPT-Neo、BERT、RoBERTaなど、多種多様なモデルを簡単に使える上、独自のモデル公開プラットフォーム(Model Hub)も存在。

- Prompt EngineeringやChain-of-Thoughtを試してみるのにも重宝する。

- LangChain / LlamaIndex(旧称:GPT Index)

- LLMを活用したアプリ構築に特化したフレームワーク。

- Promptテンプレートを管理したり、RAG(Retrieval Augmented Generation)を簡単に実装したりできる機能が充実。

- LangChainは特にチェーン(Chain)と呼ばれる流れ(ステップ)を定義しやすく、複雑なタスクのワークフローを組むときに便利。

- Auto-GPT / BabyAGI関連リポジトリ

- 「自律動作するエージェント」を実装したオープンソースプロジェクトの数々。

- ベースとなるコードをフォークして、自分のユースケースに合わせた拡張を施せる利点がある。

- まだ実験段階の機能も多いが、最新のトレンドをいち早く取り入れられる。

3. クラウド環境

- AWS(Amazon Web Services)

- Amazon S3(ストレージ)、EC2(仮想マシン)、Lambda(サーバーレス)などの豊富なサービスを組み合わせられる。

- SageMakerを使えば、モデルの学習・推論を一元管理しやすい。

- スケーラビリティが必要なプロジェクトや、大規模なデータを扱う企業向けに最適。

- Azure / GCP

- AzureはMicrosoft系ツールとの相性が良く、OpenAIサービス(Azure OpenAI)を経由してGPTモデルなどを使えるのが強み。

- GCP(Google Cloud Platform)はBigQueryなどのビッグデータ解析とシームレスに連携できる。

- いずれもMLOps向け機能が整備されていて、自動デプロイやモニタリング機能を備えている。

- オンプレ / ローカルサーバー

- セキュリティやプライバシーの観点で、オンプレが必須な場合もある。

- GPUを搭載したサーバーを準備して、自前で学習や推論環境を構築するケース。

- クラウドほど柔軟なスケーリングはできないが、機密性の高いデータを扱う企業では選択肢になり得る。

プロジェクト成功につなげるワークフロー

ここでは、エージェント開発の実務的なフローを、もう少し踏み込んで説明します。

- 目的の明確化・要件定義

- まずは「どんな問題を解決したいのか」「どんなタスクをエージェントに任せたいのか」をハッキリさせる。

- ゴールが曖昧な状態で開発を進めると、途中で仕様変更が多発してしまうリスクが高い。

- データの準備とクレンジング

- エージェントが活用するデータ(学習用、推論用、外部参照データベースなど)の整理が必要。

- 重複やラベルの誤りなどを取り除き、クレンジング作業を徹底することで、予期せぬバグを減らせる。

- RAGを取り入れるなら、検索対象となるドキュメントをEmbeddings化しておくことを検討しよう。

- PoC(概念実証)やプロトタイプ作成

- いきなり本番運用ではなく、小規模で試してみるのが鉄則。

- 例えば社内で限定的にエージェントを動かし、ユーザーの反応やシステム負荷を観測してみる。

- ここで基本的な課題や改善点が洗い出されるはずだ。

- 実装・テスト

- PoCで得た知見を元に、本格的な開発を開始。

- エージェントの主要機能(対話、タスク管理、学習アルゴリズム、エラー処理など)をモジュール化して進めると、後から改修しやすい。

- ユニットテストや統合テストをしっかり行い、特に“強化学習”や“自律動作”系の機能はシミュレーション環境で挙動を確認する。

- MLOpsを意識した継続的デリバリー

- モデルバージョン管理(モデルの更新時期や変更内容を記録)、CI/CDパイプライン、モニタリングなど、運用フェーズへの準備を欠かさずに行う。

- エージェントの挙動ログ(どんなプロンプトでどんな回答を出したか)を蓄積し、あとで分析できるようにするのも大切。

- 本番リリース & 運用監視

- いざユーザーが利用を始めると、予想外の問い合わせやエッジケースが出てくる。

- 運用チームがモニターしつつ、重大なバグや誤回答があれば素早く修正を適用。

- RLHF(人間のフィードバックによる強化学習)が導入できるなら、ユーザー評価をモデルに還元して、応答品質を高めていく。

- 改善サイクルの継続

- AIエージェントは導入がゴールではなく、使い続けてこそ真価が発揮される。

- ユーザーからのフィードバックを拾い、定期的にFine-TuningやRAG用データ更新を行う。

- 新しい機能要望やニーズがあれば、追加エージェントやマルチエージェント構成を検討していく。

現場での具体的Tips

- タスク分割の可視化

- 1つの大きなタスクを「サブタスク」の集合として整理し、エージェントの連携フローを図示すると、チーム内での意識合わせがスムーズ。

- 例えば「会話エージェント → 意図解析エージェント → 文書検索エージェント → 応答生成エージェント」のように連鎖させる。

- ログ分析とダッシュボード運用

- ログをリアルタイム可視化するダッシュボードを用意しておくと、エージェントの異常検知がしやすい。

- 「エラー率が急上昇している」「応答遅延が発生している」などのアラートを自動化すると便利。

- 小さく実践、早めに失敗

- いきなり高い精度を狙わず、最低限動くプロトタイプを短期間で作り、失敗から学ぶマインドが大切。

- この反復が、最終的に品質の高い本番システムを生み出す。

AIエージェントの未来展望

最後に、AIエージェントがこれからどのように進化していくのか、そしてどんな未来を作り出すのかを描いてみましょう。

すでにさまざまな分野で活用が始まっていますが、今後はさらに「人間との融合」や「新しい価値創造」へと進んでいく可能性が高いです!

Conversational Agentsの進化と可能性

チャットボットや音声アシスタントなど、対話型エージェントは私たちの日常に溶け込み始めています。

しかし「単に質問に答えるだけ」から、「ユーザーの意図を深く理解し、先回りした提案を行う」レベルへと進化を遂げる余地はまだ大きいんです。

具体的な進化シナリオ

- パーソナライズ度の向上

- ユーザーの好みや行動履歴を学習し、1人ひとり違う対応をリアルタイムで行う。

- たとえば、同じ質問を投げても「このユーザーは初心者だから基本説明を多めに」「あのユーザーは上級者だから専門用語を駆使する」といった個別対応が可能になる。

- マルチモーダル対話

- 音声・テキストだけでなく、画像や動画、センサー情報などの複数モーダルを統合した対話。

- たとえば、ユーザーがカメラで撮った写真をエージェントが解析して、即座に解説するような体験。

- XR(Extended Reality)やAR/VRとの組み合わせも期待され、デジタル空間でエージェントと対話できる未来が近づいている。

- 感情理解・心理的ケア

- LLMの技術が深まると、ユーザーの感情を言葉の端々から推定することが可能になる。

- 精度の問題やプライバシー課題もあるが、うまく使えばメンタルヘルスサポートやユーザーのストレス軽減に役立つかもしれない。

期待されるインパクト

- 24時間365日の対応

- 人手不足の領域(医療相談、介護支援、教育相談など)で大きな救いとなる。

- 夜間や緊急時にも適切な応答を得られるため、社会インフラとしての役割が増していく。

- 人間関係の拡張

- 今後は“デジタルパートナー”的な存在として、人々の思考や創造性をアシストするエージェントが普及するかもしれない。

- 仕事や学習、家事育児の相談役になるほか、エンタメ面でも仲間のように楽しめる対話が実現しそうだ。

さまざまな業界への応用シナリオ

AIエージェントが浸透することで、業界ごとに大きな変革が起こることが予想されます。

以下、いくつかの例を挙げますので、ぜひビジネスや研究のアイデアソースにしてみてください。

- 製造業

- 工場の生産ラインで、複数のマシンを制御するマルチエージェントが活躍し、稼働効率や品質管理を最適化。

- 自己修復や事故防止まで視野に入れたエージェントによる24時間監視で、ダウンタイムを最小限に抑える。

- 金融・保険

- 強化学習を活用したトレーディングエージェントが、リアルタイムで投資戦略を最適化。

- 保険のリスク査定でも、マルチエージェントが顧客情報や市場データを総合的に分析し、個人に合った最適プランを提示。

- ヘルスケア・医療

- 病院の受付や問診を対話型エージェントが担当し、医師の業務負荷を軽減。

- 患者が入力した症状やバイタルデータを学習し、緊急度合いの高いケースを優先的に医師に知らせるシステムを構築。

- 長期的には、在宅医療やリハビリ支援などにエージェントが入り込む可能性も。

- 教育

- 個別学習プログラムを提案し、学習進度や理解度に合わせて宿題を出したり、指導方法を変えたりできる。

- ハイレベルな生徒には高度な問題を、苦手分野を抱える生徒には基礎的な演習を、といったパーソナライズ学習が本格化しそう。

- Goal-Oriented Dialogueを使った「合格に向けた戦略指導」も期待大。

- 小売・EC

- 顧客一人ひとりの趣味・嗜好を学習し、最適な商品レコメンドを自動生成。

- 店舗スタッフ向けにも「在庫状況や仕入れタイミングを最適化するエージェント」がサポートし、無駄な在庫や欠品を減らす。

- コンビニの夜間オペレーションやセルフレジ管理にも使えるかもしれない。

- クリエイティブ産業(広告・デザイン・ゲームなど)

- アイデア出しのブレーンストーミングをAIエージェントが支援し、新しいキャッチコピーやビジュアルコンセプトを生成。

- ゲーム分野では、NPC(ノンプレイヤーキャラクター)が高度なAIエージェント化し、プレイヤーとの複雑なストーリー体験を演出する。

注意すべき課題

- 倫理面・安全面

- 人間社会に深く入り込むほど、偏見やプライバシー、透明性などの問題が浮上する。

- 特にヘルスケアや金融での誤判断は、直接的な損害・リスクにつながる可能性が高い。

- 法規制・ガバナンス

- 各国や地域でAIの利用ルールや責任範囲が整備されつつあるが、すべてをクリアにするのは容易ではない。

- セキュリティや知的財産権の取り扱いなど、ルール策定にAI側の迅速な対応が求められる。

- 人材育成

- AIエージェントを設計・開発・運用できる専門家の需要が高まる一方で、まだまだ人材は不足。

- チーム全体で機械学習の基礎知識を共有し、継続的にスキルアップする風土が必要。

とはいえ、こうした課題もテクノロジーの成熟と社会的合意によって徐々にクリアされていくと考えられます。

今こそ新しいビジネスモデルやサービスを創出するチャンスとも言えるでしょう!

まとめ

最後に、これまで説明してきた内容を箇条書きでまとめ、記事を振り返りますね。

- AIエージェントとは?まずは基本を理解しよう

- 自律的に行動し、環境と相互作用しながらタスクを遂行するAIのこと。

- 事例として対話型エージェントや工場管理など、多岐にわたる領域で活躍。

- 大規模言語モデル(LLM)とのつながり

- LLMが人間の言語理解を支え、Prompt EngineeringやChain-of-Thoughtで高度な推論を可能に。

- Zero-Shot Reasoningによって未知のタスクにも柔軟に対応できる。

- Reinforcement Learningで広がる可能性

- RLHF(人間フィードバックによる強化学習)を用いれば、応答品質や安全性を向上できる。

- Self-Healing Agentsがエラーを自動修復し、継続的に自己改善を行う未来が見えてきた。

- Model Context Protocol(MCP)やRAGを理解する

- 文脈情報を標準化するMCPが、複数エージェントの連携や情報共有を円滑に。

- RAG(Retrieval Augmented Generation)を使って外部データを参照することで、最新情報や専門知識を活用できる。

- 注目のAIエージェント事例

- Auto-GPT・BabyAGIなど、連続的にタスクを実行するフレームワークが台頭。

- Persona-based AgentsやGoal-Oriented Dialogue、Multi-Agent Systemsなど、多様な形態が存在。

- MLOpsとエージェント運用のポイント

- Fine-TuningやInstruction Tuningでモデルを業務に最適化し、継続的なモニタリングと改善が必須。

- Agent-Oriented Programmingにより、エージェント同士が協調しやすい設計パラダイムが広がる。

- AIエージェントを高度化するテクニック

- Knowledge GraphやMeta-Learning、Embeddingsなどを活用することで、知識参照や適応学習をさらに強化。

- Agent-Based Simulationが社会シミュレーションや組織改革など、多様なシーンで役立つ。

- 実装に向けたステップバイステップ解説

- 開発環境やライブラリを選定し、PoCから始めてMLOpsを意識した本番運用を目指すフローが基本。

- 適切なログ分析やテスト運用が、成功のカギを握る。

- AIエージェントの未来展望

- 対話型エージェントの進化やパーソナライズ化が進み、社会インフラとしての役割が増す。

- 製造業・金融・教育・医療など、あらゆる業界での導入が広がり、イノベーションが期待される。

最後まで記事を読んでいただき、ありがとうございました!