この記事の3行要約

- Google内部資料の情報をもとに、SEOランキングの仕組みと現実的な対策を丁寧に解説

- 検索アルゴリズムは“神のようなブラックボックス”ではなく、情報設計に応じた行動学だ

- この記事では、sourceTypeやClick Dataなどの重要項目を紐解き、実践へのヒントを提示しています

こんにちは、リュウセイです。

ChatGPT活用支援サービスをやっています。

今回の情報元は以下のyoutubeです。

動画のタイトルを日本語に訳すと「概念モデルでSEOを改善する - マーク・ウィリアムズ=クック」です。

マーク・ウィリアムズ=クック(Mark Williams-Cook)は、SEO(検索エンジン最適化)の専門家であり、YouTubeチャンネル「SearchNorwich」を運営しています。

動画の内容を要約すると、以下の通り。

- SEOへのアプローチ:彼はSEOを、個々の知識や経験を組み合わせた「概念モデル」を構築し、それに基づいて戦略を立てるべきだと主張。

- Googleアルゴリズムの理解:Googleのランキングシステムは、ユーザーに役立つコンテンツを提供することを目指しているものの、実際には利益を最大化する方向に調整されるため、そのずれを理解することが重要だと述べている。

- Googleの内部データ発見:彼は自身のチームがGoogleの内部システムを解析し、ランキング生成に関する2,000以上の内部データを発見したことを明かしている。

- この発見により、Googleがクエリとサイトを分類するために使用する多くのプロパティ、合意形成(コンセンサス)の度合い、クリック率の予測モデル、サイト品質スコアなどが明らかになった。

- このデータは、Googleのランキングシステムをより深く理解するための貴重な情報を提供している。

- ゲーム理論の応用:彼はゲームを最適化問題として捉えることに興味を持っており、特にシミュレーションゲーム「Theme Park」からSEO戦略のヒントを得ていると述べている。

- このゲームでは、チケット価格や塩分の量など、様々な要素が顧客の行動に影響を与えるように、SEOにおいても同様に、Googleが公式に発表していない要素を理解し、活用することが重要だと述べている。

- サイト品質スコア(Site Quality Score)の重要性:彼は、Googleがサイト品質スコアを付与しており、このスコアが低いとFeatured Snippetsなどのリッチリザルトの表示対象から除外されることを指摘している。

- サイト品質スコアは、ユーザーがサイトを検索する頻度、検索結果でサイトが選択される頻度、アンカーテキスト内でのブランド名の出現頻度などに基づいて算出される。

- ブランドの重要性:彼は、ブランドはGoogleのランキングにおいて重要な要素であり、過去にはブランドのないサイトがAIコンテンツを大量生成してランキング上位を獲得していたが、Googleのアップデートにより、ブランドのあるサイトが優位になるように調整されたと述べている。

- クリック率の予測:Googleはクリック率をランキング要因としては直接使用しないものの、クリック率を予測するモデルを構築しており、この予測に対してパフォーマンスを最適化することが重要であると述べている。

- SEOの経験に応じたアドバイス:SEO初心者に対しては、SEOに対する考え方を根本から変えるような情報を、経験豊富なSEO担当者に対しては、既存の概念モデルに追加できる情報を、そしてベテランSEO担当者には、さらに深い情報を提供することを目指している。

- Googleの脆弱性発見:彼は、Googleの内部システムの脆弱性を発見し、それをGoogleに報告したチームの一員である可能性がある。

僕もブログ等を通してSEOに携わっていますが、めちゃくちゃ重要なことが語られていることが分かります!

この動画の趣旨となっているのが「Googleのランキング生成に関する2,000以上の内部データが発覚」です。

なぜそれが発覚したのか?経緯は以下の通り。

- Googleの内部システムは、データ交換のためにprotobufという形式を使用している。

- protobufは、短いコードでデータを圧縮し、迅速にやり取りするためのもの。

- Googleは、このprotobuf形式で様々なエンドポイント間で情報をやり取りしている。

- あるチームが、Googleのエンドポイントを発見した。

- このエンドポイントは、Googleの内部システム間でデータがやり取りされる場所。

- チームは、ネットワークリクエストを操作することにより、このエンドポイントからデータを取得することに成功。

- 通常はprotobuf形式であるデータを、プレーンテキストに変換して取得することができたため、内容を解読することができた。

- この過程で、Googleがクエリとサイトを分類するために2,000以上のプロパティを使用していることが明らかになった。

- 9,000万件以上のクエリデータも分析された。

- これらのデータは、Googleがランキングを決定する際に使用する内部的な情報を示した。

- チームは、この発見をGoogleの脆弱性報奨金プログラムに報告した。

- この発見は、悪用されるリスクが高いと判断され、Googleから報奨金を受け取った。

- 報奨金は、慈善団体に寄付された。

実際に「脆弱性報奨金プログラム」というGoogle公式のプログラムに報告し、Googleから報奨金を受け取っているため、この情報は信憑性が高いと言えますね。

そもそも「概念モデル」とは何か?

動画を噛み砕いて記事にしたので、良ければ最後まで記事をご覧ください!

当記事は、筆者の下書きとChatGPTを合わせて執筆しています。しっかりファクトチェック済みです。

概念モデルの重要性

概念モデルという言葉を聞くと、少しハードルが高いように感じるかもしれません。

でも、複雑なアルゴリズムを理解し、効果的な戦略を立てるためのフレームワークだと思えばイメージしやすいです。

SEOは決して単なる「キーワード最適化」にとどまりません。

断片的な情報をどう組み合わせ、全体像をつかむかが重要になります。

概念モデルは、そんな複雑な仕組みを一つの地図のように整理し、道筋を見やすくしてくれる存在。

ここでカギになるのが、Googleが公開しているガイドラインと、コミュニティが培ってきた知見を合わせてまとめること。

アルゴリズムがどう動いているのか、ユーザーの検索行動とどう絡んでいるのかを推測する土台として役立つわけですね。

SEO担当者の中には、「どこまで公式情報を信用していいの?」と迷う人もいるでしょう。

実際、Google公式発表だけを鵜呑みにしていると、意外な落とし穴にハマることもあります。

そこにコミュニティの知識や自分自身の実験結果を組み込むことで、より精度の高いモデルが出来上がる。

例えば、アンカーテキストの選び方や、クリック率予測モデルの活用などは、コミュニティから得られる情報がかなり大きいです。

こうした知識を体系的にまとめ、常にアップデートしていくのが概念モデルの醍醐味。

さらに、概念モデルはGoogleの脆弱性やアルゴリズムの弱点を把握するうえでも有用です。

Googleが公式に発信しない情報をどこまで活かせるか。

その点において、このモデルをしっかり理解しておくと、アルゴリズム変更の際にも素早く対策を講じられます。

だからこそ、多くのSEOエキスパートがこの概念モデルを重視しているわけですね。

SEOに役立つ構築要素

まずは、概念モデルを実際に組み立てるうえでの構築要素についてまとめます。

下記のような要素が考えられます。

- 基本的なSEOの知識

- タイトルタグの最適化やメタディスクリプション、キーワード選定など

- コミュニティの知識

- アンカーテキストの重要性や、サイト品質スコアへの理解など

- Googleの公式情報

- ガイドライン、検索品質評価ガイド、担当者のアナウンス

- ゲームのメタファー

- テーマパークのようにルールが複雑な検索エンジンを例える

- 実際のデータと実験結果

- SEOツールのデータ分析結果や、自身が試したテスト

- Googleの弱点や脆弱性の考察

- 非公式ながら、コミュニティが検証して見つけた抜け道

- ユーザーの検索意図やクエリ分類

- ユーザー心理を理解し、適切なコンテンツを用意する

- サイト品質スコア、クリック率予測モデル、コンセンサススコア

- 内部指標として機能する要素を把握しておく

ここで大切なのは、ただ要素を並べるだけでなく、どう相互作用しているかを考えること。

サイト品質スコアが低ければ、どんなにキーワードを最適化しても上位表示が難しいかもしれません。

ユーザーの検索意図を無視してしまえば、滞在時間やクリック率が伸びないでしょう。

つまり、概念モデルは「知る」だけでなく、「組み合わせる」スキルが求められるわけです。

最先端のSEOに携わる人たちは、これらの要素を常に検証しながらアップデートしています。

公式情報とリアルな実験結果を合わせることで、より洗練されたモデルが完成します。

コミュニティ知識と公式情報の融合

Googleは、公式にアルゴリズムの全容を公表するわけではありません。

そのため、SEOコミュニティでは実験結果やデータの共有が活発です。

ここでのポイントは「自分で試す」姿勢を持つこと。

他社事例や専門家の発信に加えて、自サイトでもテストを重ねると、意外な発見があるかもしれません。

一方、公式情報には大きな価値があります。

それはGoogleの方向性を示すヒントです。

たとえば、モバイルファーストインデックスやCore Web Vitalsなどは公式にも重視されていて、その影響度合いは明白。

ただ、公式情報だけを信じると「こうしたほうがいい」と言われながら、実際の検索順位は違う方向に傾くことも。

これは、Google自身が収益の最大化を念頭に置いていることや、アルゴリズムが常にアップデートされていることが原因です。

だからこそ、コミュニティの知識を取り込むことが大切。

フォーラムやSNSで語られている事例は玉石混交ですが、繰り返し検証されている情報は信頼に値します。

自分なりの概念モデルを作り上げている人ほど、公式と非公式の両面をバランスよく取り入れている印象。

最終的に「自サイトの成果」でしか確信は得られませんが、両者をうまく掛け合わせれば、より的確なSEO戦略が見えてきます。

ゲーム「Theme Park」のたとえ

SEOの世界をゲームに例える話はたまに聞きますが、「Theme Park」というのが面白いですよね。

このゲームは遊園地の経営シミュレーションで、入場料をいくらに設定するか、どんなアトラクションを配置するかといった要素を考えながら、収益を伸ばしていくものです。

SEOも同じように、さまざまなパラメータを調整し、最適解を探す点が似ています。

特にコストを上げすぎるとお客さんが来ないとか、塩分多めのフライドポテトでドリンクの売り上げを伸ばすとか、現実世界にはない「裏技」が存在するところはSEOのアルゴリズム攻略に近いものがあります。

最適化の多層性と裏技

SEOは、ただキーワードを詰め込んだり被リンクを増やせばOKというシンプルな世界ではありません。

入場料を上げれば利益が増えるが、上げすぎれば誰も来ないというTheme Parkの話は、そのまま「過剰な最適化はペナルティを受ける」SEOの世界とダブります。

実際、キーワードを詰め込みすぎたり、不自然なアンカーテキストを多用するとGoogleから疑われるリスクが高いです。

裏技的な要素も、SEO界隈では「ブラックハット」と呼ばれるテクニックが代表例です。

クローキングや隠しテキストなど、かつては効いた裏技が今はペナルティになるケースもあります。

一方、最新の裏技としては、AI生成コンテンツの大量投入がありますが、これもヘルプフルコンテンツアップデートの登場でリスクが増しました。

だからこそ、ゲームのルールを熟知する必要があります。

裏技は一時的には効果を発揮しますが、Googleのアップデートで一気に立場が逆転することも多い。

いわば勝ちと負けが短期間で入れ替わるゲームと言えます。

SEO担当者に求められるのは、裏技に依存しすぎず、公式とコミュニティの情報を掛け合わせながら長期的に安定した順位を確保する戦略を作ることですね。

公式アドバイスと実態のギャップ

Googleは「役立つコンテンツを作ろう」と常に言いますが、実際の検索結果を見ると、必ずしも良質コンテンツだけが勝っているわけではないという現象が起こります。

これが「Theme Parkで言うマニュアルと現実とのギャップ」に近い部分。

テーマパークゲームのマニュアルには、ただ「楽しいテーマパークを作ろう」と書かれているだけでも、実際の攻略法はもっと複雑です。

SEOでも、大規模な権威サイトが独占状態になっていたり、AI生成コンテンツが上位を席巻している光景を見かけますよね。

もちろん、長期的にはGoogleも改善を重ねるので、不自然なサイトはやがて淘汰される傾向にあります。

しかしその間に稼ぎきってしまうサイトもあるので、「なぜこうなるのか」を理解しておくのは大切。

Googleも「ユーザーが求めるものを提供する」と同時に「自社の収益」を伸ばすことを狙うわけで、両者が常にきれいに一致するとは限らないということ。

だからこそ、テーマパークの裏技に似た手法が時々バズるわけです。

一方で、一度ペナルティを受けると信用回復が難しいのも事実。

Googleのアドバイスを参考にしつつ、コミュニティで検証されているリアルな手法も吸収する。

その上で、リスクを見極め、自サイトにベストなやり方を模索していくのが、今どきのSEOのスタンスでしょう。

Google公式要素とコミュニティ発見要素

Googleが公開している情報は、基本的なタイトルタグやメタディスクリプション、モバイル対応、ページ速度など、広く知られている部分が多いです。

一方、コミュニティ発で「これが効く」とされるテクニックは、公式ではあまり言及されていない部分。

例えばアンカーテキストにブランド名を混ぜるとサイト品質スコアが上がるとか、クリック率予測モデルを意識してタイトルを作るとCTRが上昇するといったことが挙げられます。

両者の活用ポイント

Google公式要素は、いわば「土台」。

ここを無視して成果を出すのは難しいです。

最低限、モバイルフレンドリーにする、タイトルや見出しを適切にする、コアウェブバイタル(速度指標)をクリアするといった部分は押さえたいところ。

一方、コミュニティが発見した要素は、「差別化」を図るための武器。

公式だけでは語られない裏を知ることで、競合より一歩先んじた最適化を可能にします。

ただし、過度にコミュニティ情報に振り回されると、根拠の薄いテクニックに手を出してしまうリスクもあります。

実験結果を見極め、自サイトでもテストするサイクルを回せるかどうかがカギ。

要は、公式をベースに据えつつ、コミュニティの知見でオリジナリティを出す形が理想ですね。

リスク管理とバランスの取り方

コミュニティ発の要素には、当然リスクも伴います。

たとえばAI生成コンテンツを大量生産して被リンクを誘導するような戦略は、一時的に成功するかもしれませんが、ヘルプフルコンテンツアップデートやその他のアルゴリズム更新で一気に沈む可能性もあります。

公式とコミュニティの情報をバランス良く活用するためには、常にテストと検証が必要。

小規模なページで試して反応を見る、SEOツールのレポートをこまめにチェックする、ペナルティが予想される行為はスモールスタートに留めるなど、リスクを分散させる工夫が大事です。

また、長期的なサイト運営を目指すなら、コミュニティ要素の中でもホワイトハット寄りのテクニックを優先すると安全度が増します。

被リンクも自然に獲得できるような高品質コンテンツを目指す、ユーザーの役に立つ追加情報を積極的に公開する、といった地道な施策が結果的に大きな信頼を得ます。

とはいえ、競合が裏技を使って大幅に順位を上げているときには、完全に無視するのももったいない場合がある。

いかにして裏技と公式情報を両立させるか。

そこがSEO担当者の腕の見せどころですね。

アルゴリズム更新が変えるSEOメタ

Googleのアルゴリズム更新は、その時々の検索トレンドや技術進歩に合わせて頻繁に行われます。

これがSEOの「メタ」を変え、そのたびに「これまで効いていた施策が急に効かなくなった」と慌てる人が出るわけです。

しかし、アルゴリズムの目標がユーザーにとって役立つ検索結果を提供することなのは変わりません。

本質的には、ユーザーファーストで作られたサイトが最終的には有利になります。

変化への柔軟な対応策

一つの決まった施策に依存してしまうと、アルゴリズムが更新された際に大ダメージを受けます。

例えば、以前は低品質な被リンクを大量に集めるだけで上位化していたサイトが、ペンギンアップデートで一気に圏外へ吹き飛ばされたケースは有名。

柔軟性を持たせるためには、以下のような視点が必要です。

- 新しい情報のキャッチアップ

- コミュニティの動向をウォッチ

- 自サイトでのテストやデータ分析

- 関係ないように見えるが、実は重要な要素(ブランドオーソリティやSNSでのシェアなど)の考慮

ブランド名の露出やユーザーのリピート率など、公式にはあまり言及されない要素が、実は大きなウェイトを占めている可能性もあります。

アルゴリズムが変化しても揺らがない基盤を築くには、コアウェブバイタルやサイト品質スコアなど、どのアップデートにも通じる要素を強化するのが有効。

短期成果と長期視点の両立

特定のキーワードで一時的に上位を狙うことだけがSEOのゴールではありません。

短期的にアクセスを集める手法は、同時にリスクが高いことが多いです。

AI生成コンテンツを大量投下して爆発的にPVを伸ばすサイトもありますが、アルゴリズムが追いついてきたら一瞬で沈むケースも見受けられます。

一方で、長期的にサイトブランドを育てるアプローチは、アクセスが急増しにくい反面、アップデートにも強く安定した集客が可能。

そこでおすすめなのが、「短期の施策と長期の施策を組み合わせる」方法。

短期ではトレンドキーワードや最新技術を積極的に試す、長期ではユーザーの信頼を得られるコンテンツをコツコツ蓄積する。

そうすることで、たとえ短期施策が失敗しても、長期施策の蓄積があるため、サイト全体がダメージを受けにくいです。

また、短期施策で得たノウハウが、長期的なブランド戦略にも生きることがあります。

アクセス解析やクリック率のデータを活用して、ユーザーが求めているものを深く理解する。

このデータこそ、サイトが成長するための大きな手掛かりとなるわけですね。

サイト品質スコアの影響

サイト品質スコアという言葉はあまり表には出ませんが、Googleが内部的にサイトを評価するために使う指標として注目されています。

このスコアは一部の特許情報やコミュニティの実験データなどから存在が推測されており、ブランド認知度やユーザーの検索行動などがカウントされるといわれています。

スコアが低いと、いくら被リンクを集めても上位に表示されにくくなるとか、強調スニペットを獲得できないなどの制約が発生する可能性があります。

計算方法と活用テクニック

講演では、サイト品質スコアは以下のような要素を中心に計算されると指摘されています。

- ユーザーがサイト名を直接検索する頻度

- 検索結果でサイトが下位でもクリックされる頻度

- ブランド名を含むアンカーテキストの総数

0.4未満だとリッチリザルトの資格を失うとされる報告もあり、かなり重要度が高いことがわかります。

そこで、ブランド名やウェブサイト名の露出度を上げる施策が重要。

SNSでの発信やYouTubeチャンネルの運営など、外部メディアを使ってブランドを浸透させると、自然検索での指名検索が増えてきます。

また、アンカーテキストにブランド名を含めてもらうには、提携先や顧客に協力を仰ぐ方法も考えられます。

特にBtoB企業の場合、取引先のサイトに掲載してもらうなど、地道なアプローチもバカにできません。

さらに、ウェブサイトの使いやすさやコンテンツの質を向上させることで、サイト名を覚えてもらう工夫をすることも大切。

一度訪れたユーザーが「このサイトは便利だ」と思えば、再訪時に直接サイト名で検索するかもしれません。

ブランド認知度とクリック率の関係性

ブランド認知度が上がると、自然検索でもクリック率が伸びやすいです。

検索結果に複数のサイトが並んでいるときに、見慣れたブランド名があると、やはり安心感からクリックされる確率が高くなるわけですね。

これが、クリック率予測モデルとの相乗効果を生みます。

Googleはポストランキングフェーズでのクリック状況を見ながら表示順位を微調整するので、ブランドへの信頼感がそのまま順位向上に繋がる可能性があるということ。

したがって、サイト品質スコア×クリック率予測モデルの組み合わせは見逃せないポイント。

ここで覚えておきたいのは、クリック率を不自然に操作するのは危険ということ。

外部サービスでクリックを誘導したりすると、ペナルティのリスクがあります。

あくまでユーザーが自然に「このサイトがいい」と思ってもらえる状態を作り上げる。

つまり、コンテンツの質やサービスの独自性、ブランド価値を高めていく正攻法が、長期的に見て最強の戦略になるわけです。

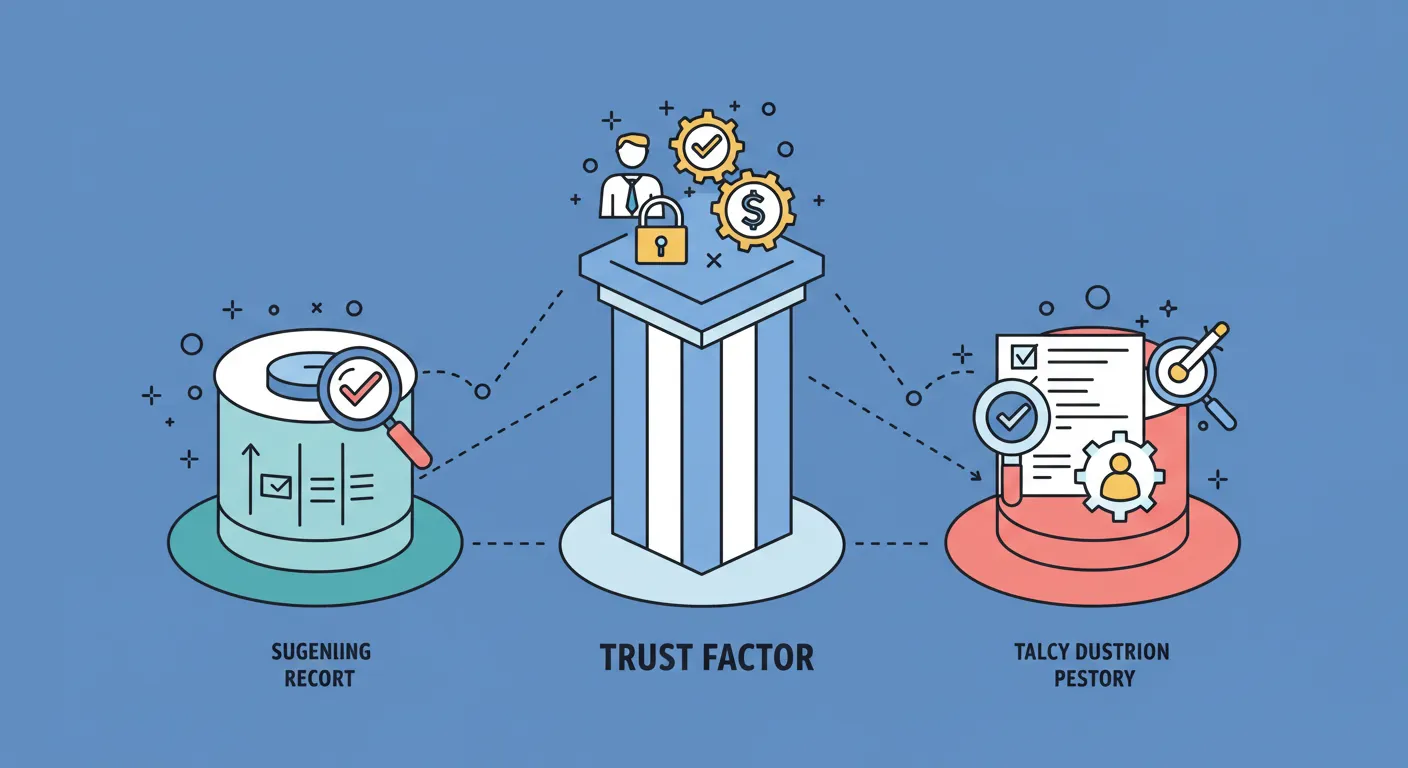

Googleが重視する3つの信頼要素

講演では、Googleがサイトの信頼性を評価する際に重視する3つの問いかけがあるとされています。

「理にかなうか」、「拡大可能か」、「証拠があるか」という3つです。

これは、Googleがどんな要素をランキングの材料に使うかを考えるときの重要な視点にもなっています。

理にかなう要因

Does it make sense?(意味があるのか?)

たとえばバウンス率(直帰率)をランキング要因にするのは本当に妥当か。

バウンス率はサイトオーナー側で操作可能(Googleアナリティクスなどの計測方法で変動させられるため)ですし、ユーザーが求める情報を短時間で得られただけかもしれない。

こうした事情を踏まえると、バウンス率そのものを直接ランキングに反映させるのは、理にかなっていないとも言えます。

しかし、バウンス率に似た指標をGoogleが推定している可能性は否定できません。

実際のコードや特許は非公開ですが、多くのSEO専門家が検証を積み重ねています。

重要なのは、「理にかなわない」と思う指標ほど盲信しないこと。

データを基に実証し、本当にユーザーの満足度と結びついているかを確かめる姿勢が求められます。

拡大可能な指標

Does it scale?(スケールは大きいか?)

Googleアナリティクスを使っていないサイトも世の中には膨大にあるのに、直接GAのデータをランキングに用いるのはスケーラブルではない。

だからこそ、Googleは独自の方法でユーザー行動を推定しているのではないかと考えられます。

たとえば、ChromeブラウザやAndroid OSなど、自社プロダクトを通じて膨大な行動データを収集している可能性がありますよね。

大規模に当てはめやすいデータでなければ、ランキング要因として組み込みにくい。

逆に、サイト品質スコアやフレーズモデルのように、全ウェブサイトに共通して評価できる仕組みならば拡張性が高いわけです。

証拠を示す情報源

Is there any evidence?(証拠はあるのか?)

講演やコミュニティで指摘される要素が、本当にGoogleのランキングに影響しているかどうかは、証拠があるかどうかが分かれ目。

証拠としては、Google社員の発言、特許文書、SEOツールの大規模データ分析結果などが挙げられます。

特に、サイト品質スコアの存在は、多方面から示唆されています。

単に「効いているっぽい」ではなく、複数の分析や専門家の言及が重なると、かなり信憑性が増します。

一方で、証拠が薄いテクニックを過剰に信じるのはNG。

コミュニティ情報の中にも、実験条件が不十分なものや、一時的に効いただけのものがあります。

最終的には、自分でテストし、継続的にデータを見続けるしかありません。

根拠のある情報を優先しつつ、自社実験で裏付けをとる。

これがSEO担当者として欠かせないマインドセットと言えるでしょう。

クリック率予測モデルのSEO活用

検索結果ページに表示されたとき、ユーザーがどれくらいの確率で自分のサイトをクリックするか。

これをGoogleはクリック率予測モデルで推定しているといわれています。

直接的に「クリック率が高いから上位」とは言い切れなくても、ポストランキングフェーズでは実際のクリック状況を踏まえて順位の微調整が行われるとも言われています。

タイトルタグ最適化とポストランキング

Google広告プランナーなどを活用すると、キーワードのCTR傾向をある程度推測できます。

このデータをもとに、ユーザーにとって魅力的なタイトルを工夫するわけです。

たとえば、数字を入れる、具体的なベネフィットを示す、感情に訴える表現を使う、といったテクニックが一般的にCTRを上げると言われています。

ここで重要なのが、サイト品質スコアやブランド認知度との兼ね合い。

いくらタイトルが魅力的でも、サイト全体が怪しいとユーザーはすぐ離れてしまうかもしれません。

逆に、ブランド力が強いサイトなら、多少シンプルなタイトルでもユーザーがクリックしてくれる可能性があります。

この組み合わせを最適化するのが「ポストランキング」でのCTR対策。

Googleは表示後のクリックや滞在時間を観察し、必要なら上位表示させることもあるとコミュニティでは言われています。

実際のところはブラックボックスですが、CTR最適化がSEOにプラスになるのは広く認められた事実。

高品質サイト運営のヒント

クリック率を上げることを目指すあまり、釣りタイトル(クリックベイト)に走るのは危険。

一時的にはCTRが伸びるかもしれませんが、ユーザーの満足度が低ければ離脱率が高まり、結果としてマイナス評価につながる可能性があります。

高品質サイトを運営するためのヒントとしては、以下が考えられます。

- 網羅的なコンテンツ:ユーザーが一度訪れたら追加の調べ物をしなくて済むレベル

- 視認性の高いデザイン:タイトルや見出しが明確で、スマホでも読みやすいレイアウト

- 専門性や信頼性:医療や金融などのYMYL分野は特に厳しくチェックされる

- ページ速度やモバイル対応:Core Web Vitalsでの高評価

こうした基本施策を押さえてこそ、CTRを高めてもユーザーの満足度をしっかり獲得できます。

結果としてサイト品質スコアも維持向上し、ポストランキングで有利に働くかもしれません。

ただ単にCTRを稼ぐだけではなく、「クリックしたあとに満足してもらえるか」が大事ということですね。

コンセンサススコアの重要性

コンセンサススコアとは、コンテンツ内の意見が一般的な合意とどの程度一致しているかを測る指標とされます。

特に「デバンキングクエリ」に代表されるような、誤情報が多い領域で重視されるとか。

たとえば、「地球は平らなのか?」というクエリに対し、フラットアース説を押すコンテンツはコンセンサススコアが低く、球体説を支持するコンテンツは高いスコアを得る可能性があります。

デバンキングクエリと整合性

デバンキング(誤情報の修正)を目的とするクエリでは、「定説」に従うコンテンツが優位になる場合があります。

政治的にセンシティブなトピックや健康にまつわる情報など、事実関係がはっきりしている領域では、コンセンサスと外れた情報を提供すると順位が落ちることも考えられるわけです。

このシステムは、一概に「マイナーな意見を排除する」ものではありませんが、誤情報や陰謀論を拡散させるコンテンツを上位に上げないための仕組みとして機能しているとみられます。

ただし、意見が分かれるトピックについては、Googleが意図的に多様な視点を混在させるケースもあるようです。

すべてのトピックで「正解」が一つとは限らないので、利用者の選択肢を残す配慮も働いているわけですね。

意見の多様性と信頼性

コンセンサススコアをあまりに過剰に意識すると、逆に独自性のない「凡庸な記事」ばかりになってしまうリスクがあります。

重要なのは、事実確認が必要なところでは正確性を重視する一方で、意見が分かれるテーマでは多角的な視点を提供すること。

専門家の見解や統計データをしっかり引用しつつ、自分なりの分析を加えれば、ユーザーにとって有益な情報となるはずです。

その結果、ユーザーの満足度が上がれば、サイト品質スコアやCTRも上がりやすくなる好循環が生まれる可能性があります。

要は、無理にコンセンサスに合わせるよりも、正確さと有益性を軸にコンテンツを作ることが最重要。

Googleのアルゴリズムが変化しても、「良質な情報を提供する」という基本方針はブレないでしょう。

8つのクエリ分類と戦略

Googleは、ユーザーの検索クエリを8つのカテゴリ(RQセマンティッククラス)に分類していると言われています。

Short Fact、BOOL、How-to、List、Definition、Opinion、Product、Other。

これらを意識することで、ユーザーの検索意図にマッチするコンテンツを作りやすくなります。

Short FactやBOOLクエリへの対応

Short Factは「日本の首都は?」のように一言で答えが出るもの。

BOOLは「はい/いいえ」で答えられる質問。

これらはAIオーバービューや強調スニペットで直接表示されてしまうことが多く、サイトにアクセスが誘導されにくい傾向があります。

とはいえ、短い回答だけで満足しないユーザーもいるので、追加情報や関連トピックをわかりやすく提供するとクリックしてもらえる可能性が高まります。

一問一答形式で終わるのではなく、さらに深い情報を用意して「もっと詳しく知りたい」というニーズに応える。

この工夫がサイト訪問へつながる鍵になるわけです。

AIオーバービューへの備え

ChatGPTなどのAIが進化していくと、検索エンジン自体が回答を生成し、ユーザーはウェブサイトを訪問せずに完結してしまうシナリオが考えられます。

これが「AIオーバービュー」と呼ばれる動きで、Short FactやBOOLクエリが特に影響を受けやすい。

対策としては、AIが生成できない価値ある情報を提供することが重要。

具体例や独自データ、専門家の意見、ユーザーコミュニティとのQ&Aなど、AIが単純に文章を組み合わせただけでは再現しきれない情報を付加するのがベター。

さらに、How-toやOpinion、Product系のクエリに注力するのも戦略の一つ。

実際に手順を踏む記事やレビュー記事は、AIだけでは書きにくい要素を盛り込みやすいです。

今後、AIがさらに発展しても、「人間だからこそできる情報提供」を追求する姿勢が求められます。

ヘルプフルコンテンツアップデートの教訓

Googleが2022年頃から導入したヘルプフルコンテンツアップデートは、大量のAI生成サイトや、ユーザーに役立たないコンテンツを量産するサイトに大きな衝撃を与えました。

「実際に読んでみると意味のない文章が並んでいる」ようなサイトが大幅に順位を落とす一方、ユーザーファーストのコンテンツを真面目に作っていたサイトが相対的に評価されやすくなったわけです。

ユーザーファースト重視の必要性

このアップデートが示す通り、ユーザーに役立つ情報を提供しないサイトはいずれ淘汰される可能性が高いです。

低品質なAIコンテンツや、リンクだけで稼ぐアフィリエイトサイトは短期的に成功しても、Googleの手が回ると一気にランクダウンする。

逆に、ユーザーファーストを徹底していれば、アルゴリズムが変わっても致命的な打撃を受けにくい。

検索意図に合わせてコンテンツを設計し、専門的な情報にはエビデンスを提示し、サイトの使いやすさにも配慮する。

こうした地道な施策が、ヘルプフルコンテンツアップデート後の世界で信頼を勝ち得る鍵。

ブランド構築と長期的視野の重要性

アップデートの影響を受けたサイトの特徴の一つは、ドメインオーソリティが高くてもブランドオーソリティが低いケースです。

つまり、被リンクがたくさんあっても、ユーザーがそのサイトを全然知らない状態。

検索エンジンを通じて偶然アクセスしてみたら、実態のないAI記事がずらっと並んでいた、といった具合です。

ここで明らかになったのが、ブランド認知度の大切さ。

ユーザーが直接サイト名を検索したり、SNSで言及するようになれば、Googleも「このサイトは本当に支持されている」と判断しやすくなります。

結果としてサイト品質スコアが高まり、リッチリザルトの獲得や上位表示が狙いやすくなる。

しかも、こうしたブランド価値は短期で築けるものではありません。

地道に信頼を積み上げ、業界やコミュニティで評価されるようになって初めて実感できる。

だからこそ、長期的視野でサイト運営を考え続けることが、アップデート対策として最良の戦略と言われています。

まとめ

ここまで、Googleのランキング生成に関する2,000以上の内部データが発覚というテーマを軸に、概念モデルやサイト品質スコア、クリック率予測モデル、コンセンサススコアなど、多岐にわたって解説してきました。

非常に長文になりましたが、主なポイントを振り返ります。

- 概念モデル:断片的な情報を統合し、アルゴリズムの全体像を理解するフレームワーク。公式情報とコミュニティ知識をうまく融合すると効果的

- ゲーム「Theme Park」のたとえ:最適化の多層性や裏技の存在、公式アドバイスと実態のギャップを示すにはもってこいの例え話

- Google公式要素とコミュニティ発見要素:両者をバランスよく活用し、リスクをコントロールしながらオリジナルのSEO戦略を構築

- アルゴリズム更新とSEOメタ:変化への柔軟な対応が鍵。短期成果と長期視点を両立し、ブランド価値を育てるのが賢明

- サイト品質スコア:ユーザー検索行動やブランド名のアンカーテキストなど、内部的な指標で大きな影響力を持つ。0.4未満だとリッチリザルトの資格を失うとの指摘も

- 3つの信頼要素(理にかなうか、拡大可能か、証拠があるか):Googleがランキング要因を判断する際の重要な基準。過剰に噂だけを信じるのは危険

- クリック率予測モデル:タイトルタグを最適化してCTRを高める施策。ポストランキングで順位調整が行われる可能性があるため注視

- コンセンサススコア:一般的な定説と合致する度合いを測る仕組み。デバンキングクエリでは正確性がより重視される

- 8つのクエリ分類:Short FactやBOOLクエリへの対策、AIオーバービュー時代に備えた戦略を検討

- ヘルプフルコンテンツアップデート:ユーザーファーストを徹底しないサイトに厳しいアップデート。ブランド構築と長期運営がポイント

これらを踏まえると、やはり最終的にはユーザーにとって役立つ情報をしっかり届けることが最重要だと再確認できます。

ただ、Googleのアルゴリズムは常に収益やシェア拡大を狙って進化するので、公式発表を信じるだけでは不十分。

コミュニティの知識や実験結果を取り入れつつ、自分自身のサイトのデータで検証を繰り返す姿勢が欠かせません。

また、ブランドオーソリティを育てる施策を並行して進めることが、長期的な安定の秘訣になるでしょう。

SEOはある意味で複雑なゲームですが、ゲームのルールや裏技を学び、適切に活用すれば勝ち筋は見えてきます。

ぜひ今回の内容を参考に、自分だけの概念モデルを作り上げてみてください。

それでは、今回はこれで終わりです。

読んでいただき、ありがとうございました!