この記事の3行要約

- Model Context Protocol(MCP)とは、AIが外部ツールと連携しやすくする新基準のこと

- 業務の効率化、社内検索、情報整理などの自動化が一気に進む未来のインフラとなる

- 本記事ではMCPの仕組み、導入手順、活用上の注意点までをまとめて解説しています

こんにちは、リュウセイです。

ChatGPT活用支援サービスをやっています。

今回はModel Context Protocol(MCP)のテーマで記事を書いていきます。

あなたは「AIアシスタントと外部サービスを手軽につなぎたいなあ…」と思った経験はありませんか?

例えば、Google Driveにある社内資料を一瞬でチェックして要約したり、Slackの議論を自動整理して「見逃しがないか」見守ってほしかったりすること、ありますよね?

実はそれを叶えてくれる仕組みが、Model Context Protocol(MCP)なんです。

本記事では、MCPの基本からメリット、活用事例、さらに導入手順や注意点までたっぷり解説していきます!

ぜひ最後まで読んで、AIエージェントが外部データを自在に扱える未来を一緒にイメージしてみてください。

MCP自体は無料で導入して使えますが、AI APIのキー登録が必要であり、LLMを呼び出してチャットをさせます。そのため、APIの使用量に応じた従量課金が発生します。「MCPは無料だがAPI料金がかかる」という点だけ押さえておきましょう!

当記事は、筆者の下書きとChatGPTを合わせて執筆しています。しっかりファクトチェック済みです。

MCPの基本概念

まずはMCP(Model Context Protocol)というものが何なのか、背景とともにお話しします。

僕自身も初めて聞いた時、「おや、今度はどんなプロトコルが出てきたんだろう?」と興味津々でしたが、その概要を知るうちに「これは革命的だ!」と感じたんです。

MCPが生まれた理由とは?

今の時代、AI(とりわけ大規模言語モデル)の進化が目覚ましいですよね。

ところが、AIが実際の業務や生活で使われる際、外部ツールやデータと連携させるのに苦労しているという現場の声をよく耳にします。

例えば

- 「Google Driveのファイル検索を自動化したいけど、APIの認証周りが面倒…」

- 「Slackからメッセージを読み取って、要点をレポートしたいけど、ツール連携が一筋縄ではいかない…」

- 「外部サービスごとにプラグインを作るのも大変で、しかも全部仕様が違う…」

こういう状況だと、せっかくAIが賢くてもデータの孤島になってしまい、活かしきれないわけです。

そこでAnthropic社が提唱したのが、Model Context Protocol(MCP)です。

要するに、AIと外部ツール・データソースをつなぐためのオープン標準を定義して、「一度作れば多方面で使いまわせる」仕組みにしてしまおうというわけですね。

たとえるなら“AIのUSB-Cポート”

イメージしやすいように例えると、USB-Cポートってありますよね?

昔はケーブル規格がバラバラで、スマホ充電器だけでも形状が違いすぎるし、PC接続もごちゃごちゃだった。

でもUSB-Cが普及してからは、どんなデバイスでも基本はUSB-CでつなげばOK、という流れになりつつあります。

MCPも同じで、AIとツールを接続する“ポート”を共通化する狙いがあるんです。

Google DriveやSlack、GitHub、データベース、その他いろんな外部リソースを、MCP対応という形で接続すれば、AIモデル(ホスト側)は一元的にそれらを扱えるようになります。

これがなぜすごいかというと、従来は外部ツールごとに独自の連携実装が必要で保守が大変だったのが、MCPのおかげで「MCP→ツール」という一本化されたルールで済むからなんですよ。

企業やチームが抱えていた課題を解決

僕がいろんな企業さんのAI活用相談に乗ってきた中でも、複数のSaaSを使ってる現場では連携に苦労していました。

「Driveから引っ張った資料をAIに要約させたいが、その間にSlack連携も挟むし、認証が複雑で…」といった具合です。

MCPはこうした“バラバラAPIをまとめる”標準となるので、開発・保守コストが大きく下がるはずだと期待されています。

このように、MCPが標準化することで、企業やチームが抱えていた“AI活用の連携地獄”を解消し、スケーラブルなAIエコシステムを構築できるようになるわけです。

MCPの仕組み

では、MCPがどうやって実装されているのか、ざっくり解説していきますね。

仕組みの部分は、少し技術寄りになるかもしれないので、なるべく噛み砕いて話そうと思います。

クライアントとサーバーの関係

MCPでは、ホスト(AIアシスタント側)と、サーバー(外部データ・ツール側)という二つの役割に分かれます。

ちょっと紛らわしいですが、「サーバー」と呼ばれるプログラムは、Google DriveだったりSlackだったり、外部のサービスを扱う窓口なんですよね。

そしてホスト側はAIモデルを抱えたアプリケーションで、ユーザーが実際に触れるチャット画面などを提供する側。

両者はJSON-RPC 2.0という軽量プロトコルで通信を行います。

要は、「AIがDriveサーバーに“ファイル検索して”とリクエスト→Driveサーバーが該当ファイルを返す」というやり取りが、共通ルール(MCP)に沿ってやりとりされるんです。

これにより、ホスト→サーバー間の実装が一元化され、ホストが変わってもサーバーが変わっても同じ手順で通信できる仕組みになっています。

リソース・ツール・プロンプト

MCPには3つの重要な概念があります。

- リソース(Resources)

ドキュメントやファイル、データベースのレコードなど、AIが読み取れる情報を指します。

例えばGoogle DriveのPDFファイルとか、Slackメッセージ履歴とかですね。

サーバー側はこれをURIなどで管理し、AIが必要なときに提供します。 - ツール(Tools)

AIが実行できる“操作”や“行動”を指します。

たとえば「Slackにメッセージ投稿」「GitHubのPull Requestを作成」といった機能がツールとして定義され、AIがリクエストすることで実行できる。 - プロンプト(Prompts)

あらかじめ定義された対話テンプレートや処理フローです。

サーバー側で「この場面ではこういう指示が効果的」といったプリセットを持っていて、ユーザーがワンクリックで使えるように提供するイメージです。

これらの概念を一つのプロトコル下で扱うのがMCPの特徴。

AIアシスタントは「必要なリソースを呼び出す」「必要ならツールを実行する」という形で外部サービスを使えるようになるわけです。

これって、まるでAIが自分専用の秘書(サーバー)に“あれやっといて!”と頼んでいるような状態なんですよ。

JSON-RPC 2.0と通信の流れ

通信自体はJSON-RPC 2.0という形式に準拠しています。

- 初期化ハンドシェイク

AIホストがサーバーに「僕はバージョン○○対応だよ。そっちは?」と聞き、サーバーが「こちらもバージョン○○OKです」と応答。

これでお互いが対応機能を把握する。 - リクエスト/レスポンス

ユーザーが「Driveから資料を検索してほしい」とチャットでAIに頼むと、AIホストがサーバーに「searchFiles」みたいなリクエストを送る。

サーバーは実際にDrive APIへアクセスし結果を取得、「こんなファイルがありましたよ」とレスポンス。 - ツール実行時の承認

ツールによっては「危険な操作」(例:ファイル削除、外部送信など)もあるため、AIが実行を提案したらユーザーの承認を挟む仕組みが一般的。

これでAIが勝手に重要データを消してしまうリスクを抑えられます。 - 終了

どちらかが通信を閉じると接続終了。

こうしたフローが標準化されているので、個別サービスとのやり取りを一本化できるわけです。

このあたりの仕組みはLanguage Server Protocol(LSP)に着想を得ているらしく、開発者の間では「なるほど、LSPのAI版か!」なんて言われることも多いですね。

本質的には、「AIの世界と外部データの世界を結ぶREST的なプロトコル」と考えるとイメージしやすいでしょう。

RESTとは:ウェブ上のデータに簡単にアクセスしたり操作したりできるよう決められたルールのこと。

MCPのメリットと特徴

ここまで聞くと、なんとなく「MCPって便利そう!」と思ってもらえたかなと思います。

実際に僕も、MCPがもたらすメリットはめちゃくちゃ大きいと感じています。

ここからは具体的な利点について掘り下げていきますね。

開発効率と保守性のアップ

最大のメリットはやっぱり「一度サーバーを作れば、いろんなAI・ツールで使いまわせる」ってところ。

従来は、例えばGoogle DriveとAIを連携するにはカスタム開発、Slack連携にはまた別のプラグイン…と、実装や保守が煩雑でした。

しかしMCPなら、MCP対応サーバーを一つ用意しておけば、それをClaudeやVS Code拡張、将来的にはChatGPTなど、複数のAIやアプリから呼び出せるわけです。

- 初期コストの削減

連携処理が標準プロトコルでまとまるので、ツールごとにコネクタを何本も書かなくていい。 - 保守コストの低減

変更や追加があっても、MCPサーバー側を更新すればOK。AIホスト側は共通手順なので手直しが少ない。

要するに“プラグイン地獄”から開放されるんです。

「この一元化はホントありがたい…!」と、AI導入を考えている企業の担当者さんなら言いそう。

僕自身も「Drive、Slack、GitHub連携を全部まとめて管理できるなら、こんなに楽なことはないな」と感じますね。

安全性と権限管理

AIが外部ツールを扱う際に懸念されるのが「勝手に機密ファイルを読み取られたらどうしよう?」とか、「勝手にデータを消されたら?」という不安。

MCPでは、サーバー側で細かいアクセス範囲や操作権限をコントロールできる仕組みが備わっています。

- ユーザー承認を挟むワークフロー

データ削除や外部共有といった操作ツールには、事前にユーザーのOKが必要になる設計を入れられる。 - アクセス範囲の限定

例えばGoogle Driveサーバーなら特定フォルダだけ、Slackサーバーなら特定チャンネルだけ、といった範囲設定が可能。

これらはMCPに準拠した「ツールやリソース提供の仕組み」として標準化されているので、ログイン制御や承認フローなどを一貫して設計できるんですよ。

結果的に「データが外部に漏れる」「危険操作をAIが無断でやっちゃう」リスクを最小化できるというわけです。

幅広いツール連携

MCP対応のサーバーはすでに続々と登場していて、Anthropicが公開する公式リポジトリには、Google Drive、Slack、GitHub、GitLab、PostgreSQL、Puppeteer(Web自動操作)など多数が並んでいます。

有志のコミュニティ開発も活発で、AWS連携、Azure連携、メール送受信、カレンダー管理などのサーバーがどんどん増加中。

僕が「これは便利!」と思ったのが、“複数ツールをまたいだ自動化”です。

たとえばAIホストが一度に「Google Driveの資料を探し、その要約をSlackに投稿し、関連タスクをGitHub Issueに登録する」なんて流れを、ワンストップでやってくれる未来が見えてくる。

それぞれの操作はMCPサーバーが担当して、AIはMCP越しに命令を出すだけなので、ユーザーからは「ちょっと指示したら全部やってくれる!」という体験になるんですよね。

AIエージェントの高度化

さらに、MCPが普及すると“AIエージェント”という概念もよりリアルになってきます。

エージェントAIは、「ユーザーの指示なくても自律的に判断して、必要なツールを使って課題解決する」みたいな動きをしますよね。

従来はツール連携コストが大きくて、エージェントに何でもやらせるのは難しかったけれど、MCPが標準化されれば、エージェントが多種多様な外部リソースに自然にアクセスしやすいのです。

例えば…

- ①AIエージェントが「今のSlack状況からタスクが遅れているかも」と判断

②GitHubでIssueを立てる

③チームに進捗報告を投稿 - ①リアルタイムデータを取得して分析

②Googleスプレッドシートに結果を書き込む

③必要に応じてMailサーバーからアラートを送る

…みたいなワークフローが人手なしで回る、という可能性が広がりますよね。

これは僕も将来的に「AIが自発的に働いてくれる時代」を想像できてワクワクします。

MCPの活用事例

じゃあ、実際にMCPがどう使われているか、または使えるのか?

僕が面白いと思う事例をいくつか紹介します。

これを読むと、あなたも「こんなことできるじゃん!」とイメージが沸くはず!

1. Google Driveでの資料検索

超定番ですが、やっぱり便利なのがGoogle Drive連携。

会議前に「去年の年末の議事録ってどれだっけ…」と手探りで探すのは面倒ですよね。

MCP対応のDriveサーバーを使えば、AIに「昨年12月の議事録ファイル、探して共有リンクを生成して」と一言お願いするだけ。

実際にAnthropicのデモでも、「Claude(AIアシスタント)がDriveのファイル検索 → ユーザー指定 → 共有権限の設定 → リンク取得…」というフローを一瞬でやっていました。

これ、地味だけどめちゃくちゃ時短になるんですよ。

会議直前に資料の準備をAIに丸投げできるのは本当に助かりますよね!

2. Slackでのプロジェクト進捗まとめ

Slackを使っているチームや会社は多いですよね。

でも、チャンネルやDMが多すぎると「誰が何言ってた?」と追い切れない。

MCPでSlackと連携すれば、AIが適宜メッセージを集約し、「今週の進捗まとめレポート」を自動生成してくれるようになります。

例えば

- プロジェクトXのチャンネルを過去1週間分読み込み

- 重要メッセージを抜粋して箇条書き

- 未解決タスクをリストアップ

- あなたに共有

さらに「必要ならSlackにメッセージを投稿してチームに周知しておいて」といった具合に、会話から行動まで一貫してAIがやってくれる!

こうなると、プロジェクトマネージャー的な役割をAIが代行するイメージですね。

3. GitHubのコード管理とIssue作成

エンジニア界隈では、GitHub連携が熱い話題。

AIがリポジトリのコードを直接読み込んでレビューしたり、Issueを立てたり、Pull Requestを作成するなんて流れがMCPで実現します。

想像してみてください。

「このファイル、ちょっとバグがありそうだから修正案をコミットしてPull Request出しておいて」と頼むと、AIがコードを修正し、ブランチを切ってPull Requestを出し、Slackでチームに通知…なんてことまで自動化可能。

まさに“AIペアプロ”どころか“AIが代理でコード運用”してくれる時代が来るかもしれません。

4. データ分析とレポート作成

データベース(SQL系)や外部APIと組み合わせれば、リアルタイム分析だって簡単です。

例えば、株価API+社内売上DB+AI要約という3つの組み合わせで、マーケットの動向と自社売上を照らし合わせたレポートを自動生成できるとか。

エクセル操作やCSVインポートなどを手動でやっていた手間が激減し、「AIに指示するだけでダッシュボードが更新される」なんて状態も夢じゃありません。

「MCPでデータ抽出 → グラフ生成 → Slack投稿」をワンフロー化したという人もいるらしく、凄まじい効率化を実現しています。

5. 複数サービス連携のクロス・ワークフロー

MCPが本領を発揮するのは、複数ツールを組み合わせて動かすとき。

- Driveのファイルを探す

- Slackで報告

- GitHub Issueを作る

- さらに社内DBに記録

- 完了したらまたSlack報告

といった繰り返しのフローが全部ワンストップになるわけです。

「単にAIが回答を返すだけ」じゃなく、“実際にアクションを起こしてくれるAIエージェント”がリアルに存在できるようになるのがポイント。

「Driveから持ってきた資料で新規案件のフォルダ作って、そのリンクをSlackに貼っておいてね」なんてお願いをした時、AIがササッと実行してくれるとめちゃ快適ですよ!

MCPの使い方と導入手順

さて、では実際にMCPを導入するにはどうすればいいのか?

ここからは具体的な手順や環境構築のポイントなどを、初心者にも分かるように解説していきます。

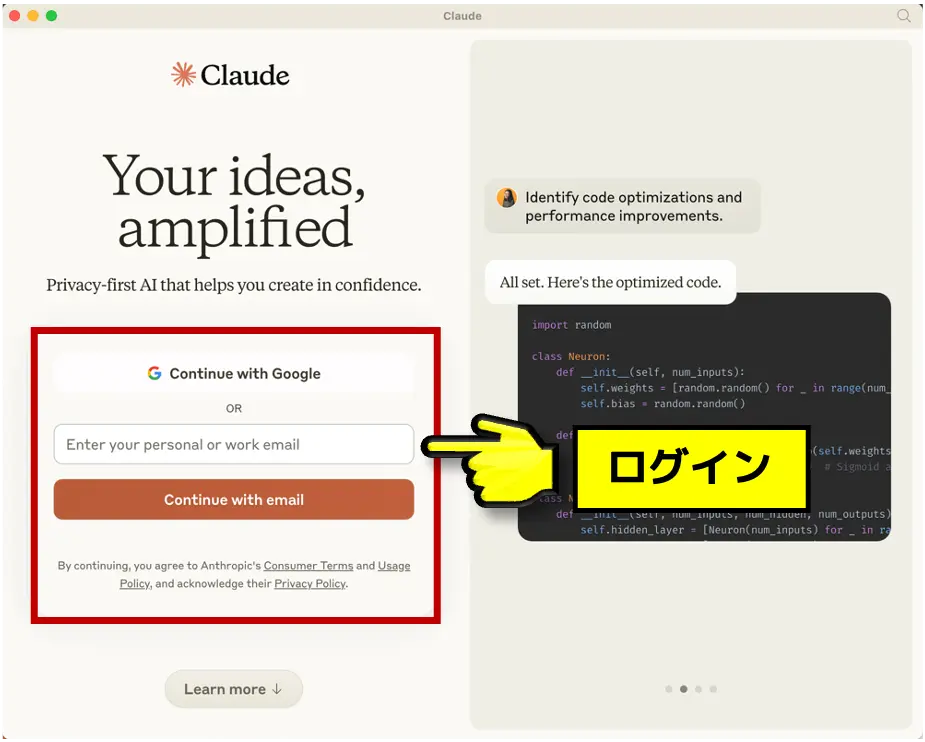

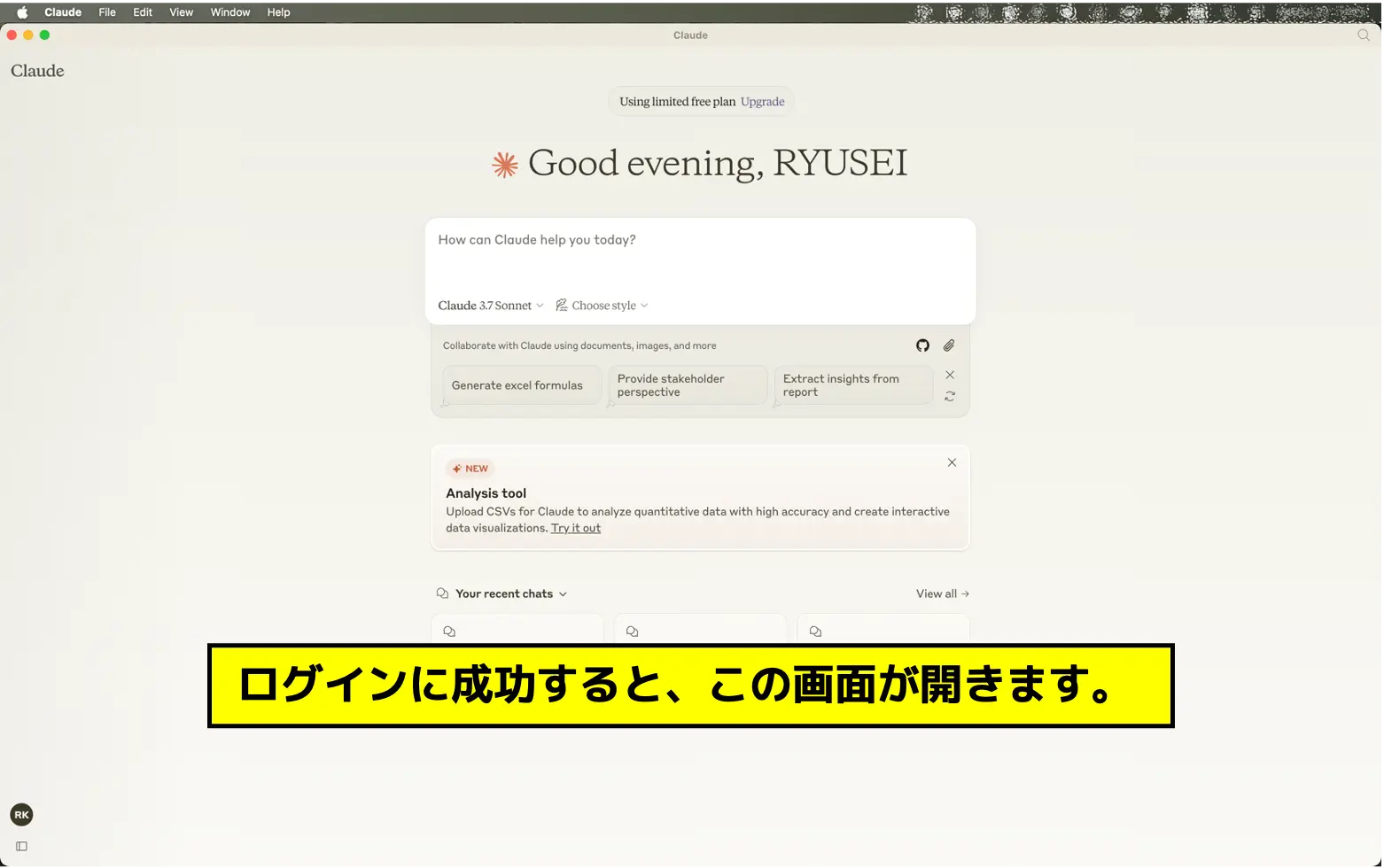

1. MCP対応のホストアプリを用意

まず、MCPに対応したホストアプリが必要です。

現時点(2025年3月9日)で手軽に使えるのは、Anthropic社のClaude Desktop。

これはPC向けのチャットアプリで、あらかじめMCPに対応していて、設定画面からサーバー接続を追加できます。

他にもVS Code拡張の「Cline」など、開発向けのホストが続々と出てきていますが、初心者はClaude Desktopが一番導入しやすいでしょう。

- 公式サイト(Anthropicのページ)からClaude for Desktopアプリをダウンロード。

- Anthropicアカウントを作成してログイン。無料プランでOK。

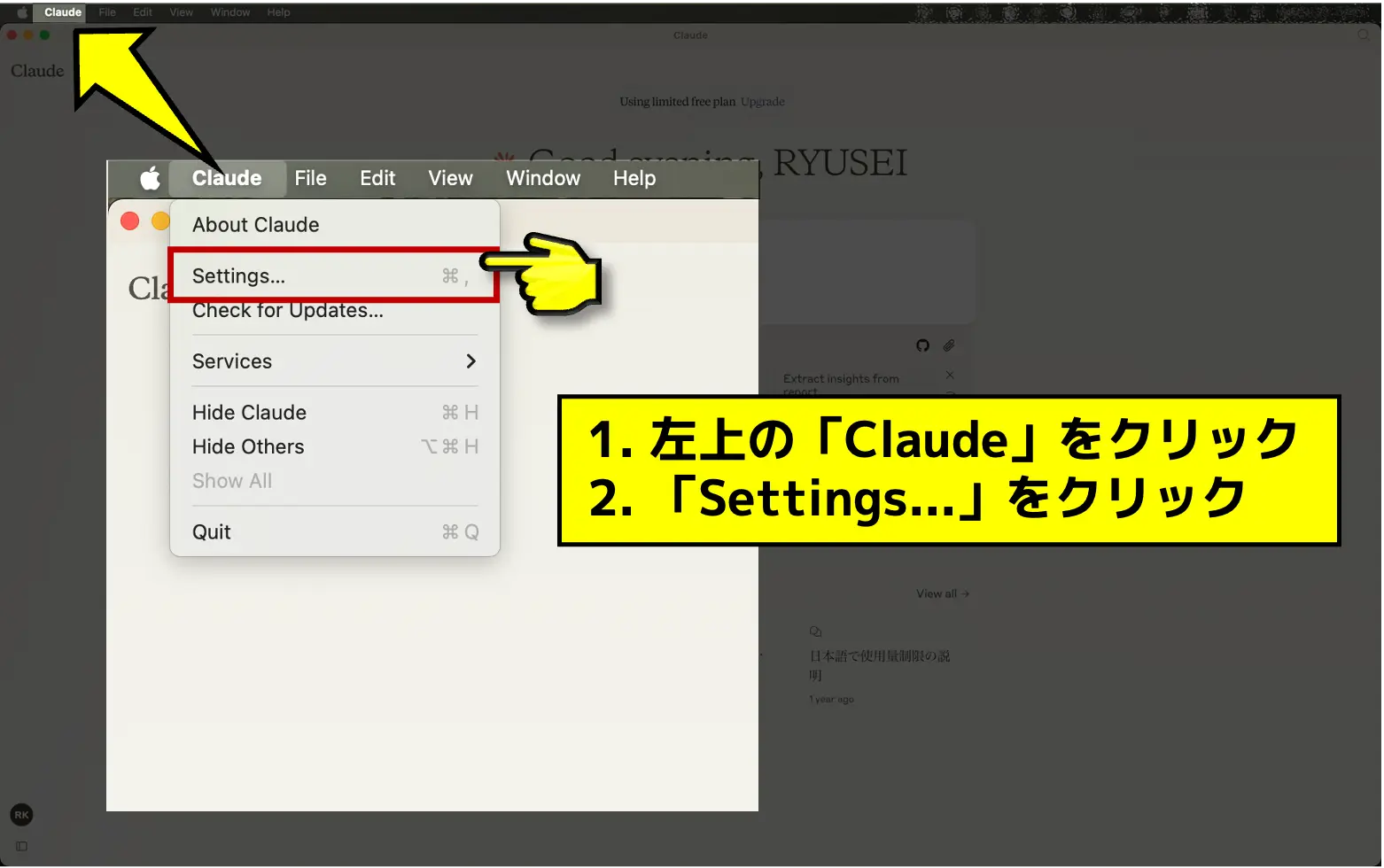

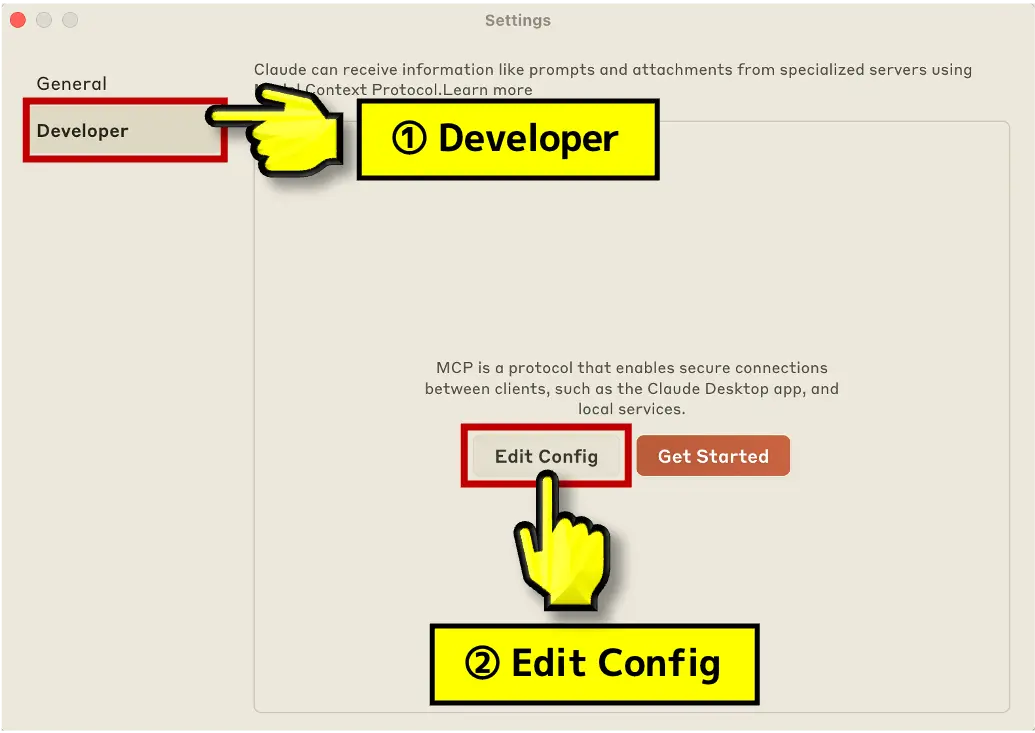

- アプリが起動したら、左上の「Claude」をクリック。

- 展開されたメニューから「Settings…」をクリック。

- 「Developer」にタブを切り替え、「Edit Config」をクリック。

Claude_desktop_config.jsonが開くので、ここに接続するMCPサーバーの記述を書く。

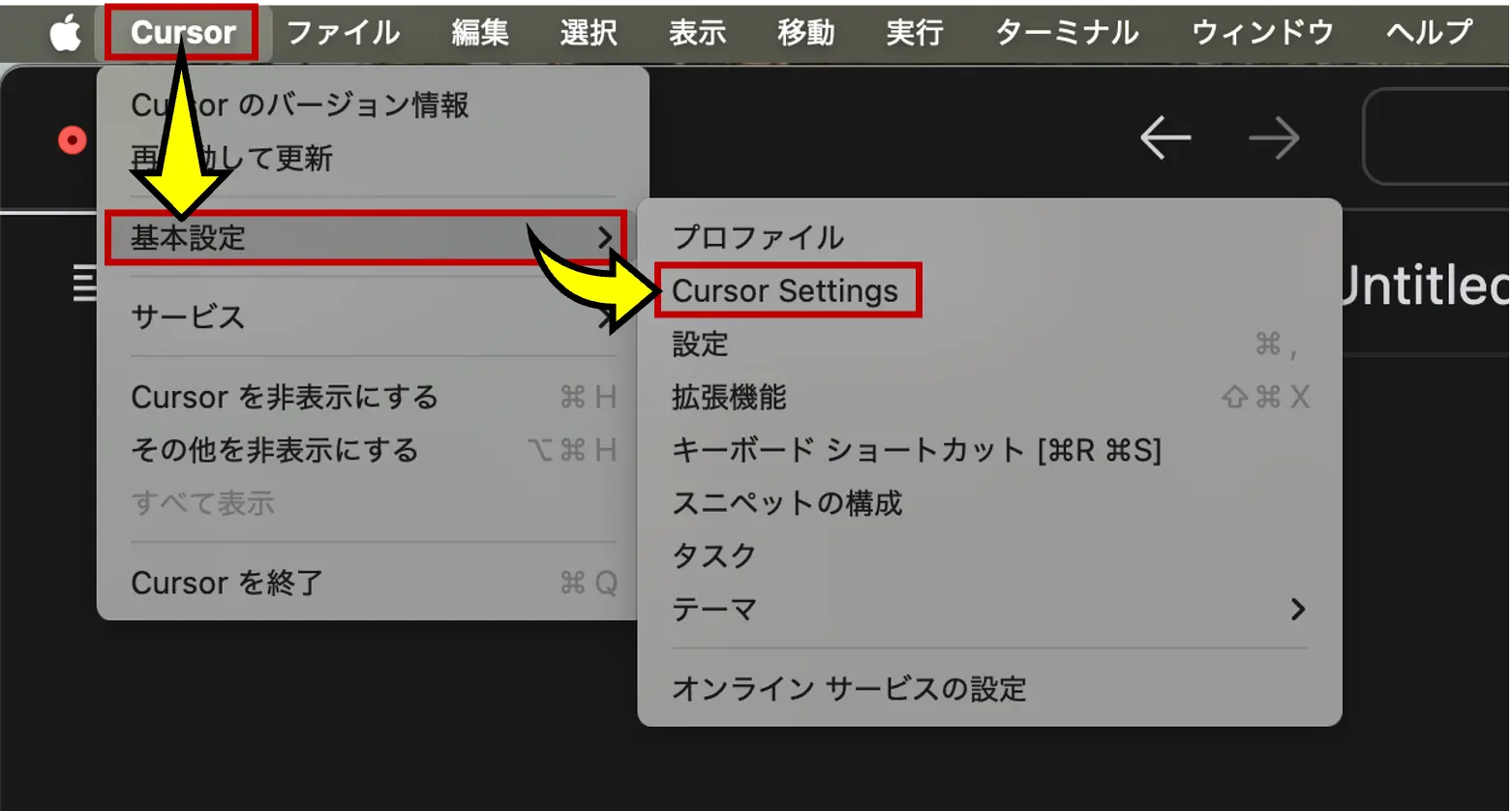

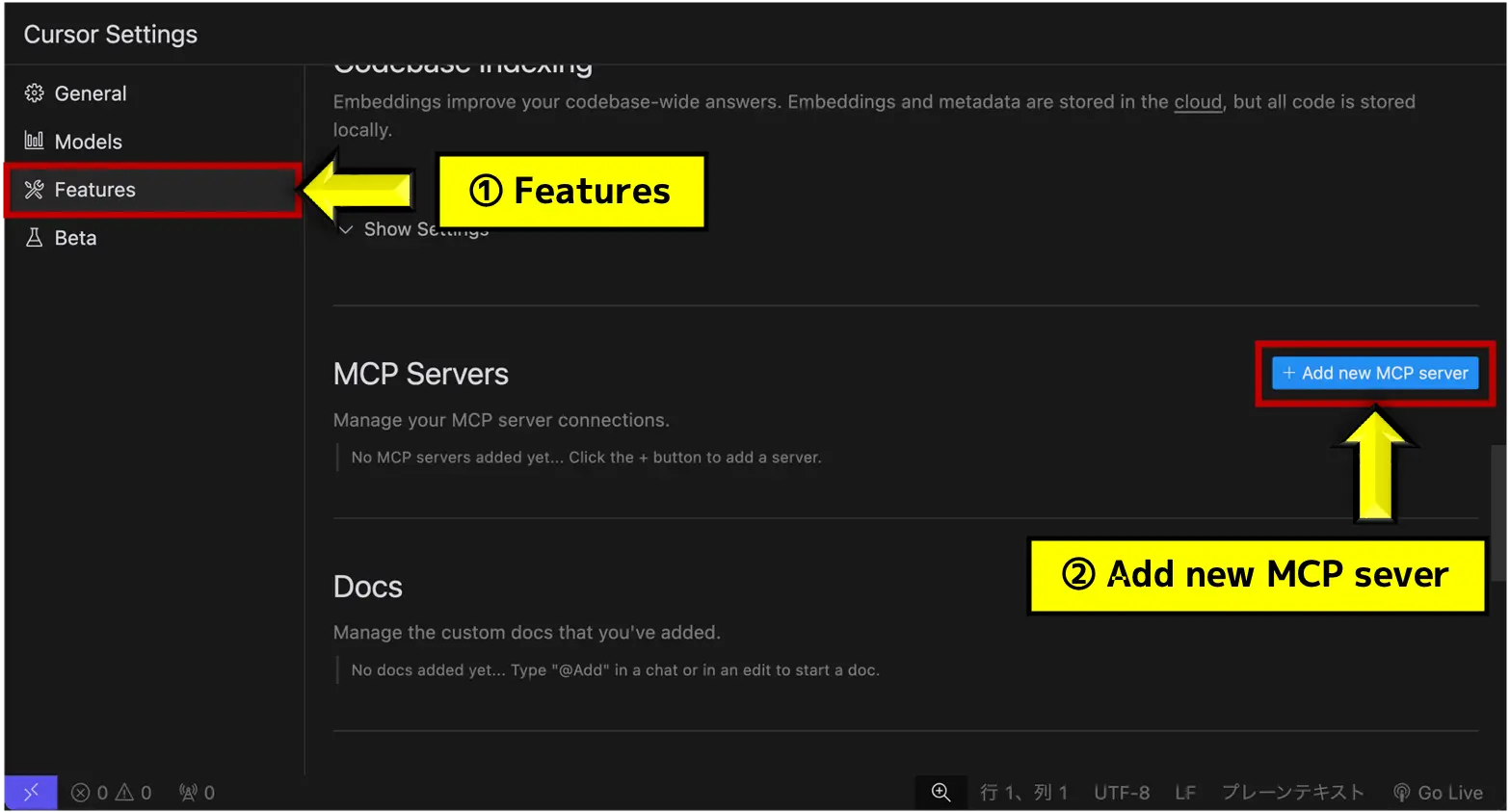

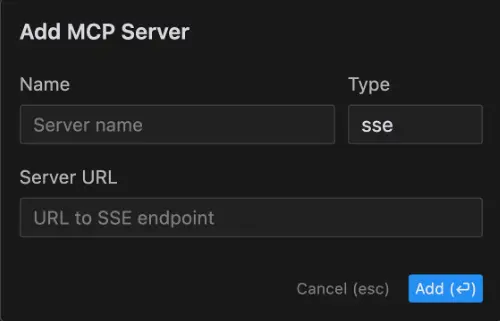

Claude_desktop_config.jsonのファイルが開くので、そこにMCPサーバーの設定を書き込む(エディタを持っていないと開かない可能性アリ)。ちなみに、AIプログラミングエディタの「Cursor(カーソル)」でもMCPをサポートしています。

2. MCPサーバーを起動

続いて、「どのツールと連携したいか」決めて、そのツール用のMCPサーバーを用意します。

例えばGoogle Drive連携ならMCP Server for Google Driveといったパッケージが公式リポジトリやNPM、PyPIなどで公開されているんです。

多くの場合、Node.jsまたはPythonで動くことが多いので、環境を整えて以下のようにコマンドを実行します。

npx @modelcontextprotocol/inspector npx server-googledrive初回起動時にはGoogleアカウント連携のOAuth画面が出たりするので、許可を与えておくと、MCPサーバーが「ドライブの中身を検索する権限」などを取得します。

このあたりはサーバーごとに手順が異なるので、GitHubのREADMEなどを読むといいですね。

Slackサーバーを起動したければ「Slack Bot Token」をセットして起動、GitHubなら「GitHubトークン」を用意する、といった具合で認証情報をサーバー側で保持します。

3. Claude Desktopにサーバー情報を登録

サーバーを起動したら、今度はClaude Desktopに「このサーバーに接続してね!」と教えてあげる必要があります。

設定ファイル(JSON)またはGUIから、ホスト名と通信方式(HTTP or STDIO)などを指定。

例えばHTTPで動かしているなら、localhost:4000みたいにURLとポートを入れておきます。

Claude Desktopを再起動すると、設定を読み込んで「Google Driveサーバーが見つかった!」と認識してくれます。

- 設定例(HTTPの場合)

"mcp_servers": {

"drive": {

"transport": "http",

"url": "http://localhost:4000"

}

}- 設定例(STDIOの場合)

"mcp_servers": {

"drive": {

"transport": "stdio",

"command": "npx server-googledrive"

}

}こうして接続が成功すると、Claude Desktopのチャット画面に“MCPが有効になっている”ことを示すアイコンやツール一覧が出るようになります。

4. チャットで試してみる

最後に、実際にチャット画面で「Driveにある○○の資料を探して」とAIに話しかけると、裏でMCPサーバーにリクエストが飛び、検索結果が返ってきます。

あなたは普通にAIに指示しているだけなのに、AIが外部リソースを見に行ける状態になっているというわけです。

「Slackの最新メッセージをまとめて」「GitHubのIssue一覧を教えて」「Driveのファイルを編集して」など、MCPサーバーがサポートしている機能を次々に使い倒すのは、もはや夢のような体験だと思いませんか?

MCP自体は無料で導入して使えますが、AI APIのキー登録が必要であり、LLMを呼び出してチャットをさせます。そのため、APIの使用量に応じた従量課金が発生します。「MCPは無料だがAPI料金がかかる」という点だけ押さえておきましょう!

MCPを使う際の注意点とリスク管理

MCPをいざ運用するとなると、セキュリティ面や運用面での配慮が欠かせません。

規格を一元化できるMCPのような強力な技術ほどリスクコントロールが重要ということです。

MCPはまさに「AIが外部リソースに自在にアクセスできる」仕組みですから、人間側でどんなルールを設けるかが成功のカギになります。

ここからは、MCP導入後に意識すべきポイントや起こりうるトラブル、セキュリティ対策の具体例などを詳しく書いていきます。

「めちゃくちゃ便利だけど、何に気を付ければいいの?」と不安に思っているあなたも、ぜひ参考にしてみてください。

セキュリティとプライバシー保護

まず一番大事なのは、情報漏洩リスクを最小限に抑えること。

MCPサーバーを用意してAIが自由に外部ツールを使えるようになる、ということは、裏を返せば「もし権限設定をミスったら、AIが見なくていいデータまで全部見れちゃう」可能性があるということです。

これらの仕組みは、MCPを導入する上で必須レベルといっても過言ではありません。

AIにやらせたい作業と、絶対やられたくない作業の境界を明確に線引きして設定しておきましょう。

技術トラブルへの対処法

運用を始めると、接続エラーやバージョン不一致、ネットワーク問題など技術的なトラブルに出くわすこともあります。

しかし幸いなことに、MCPは開発者向けのデバッグ手段が充実していて、比較的問題解決しやすいのがメリットです。

MCP自体はまだ進化中のプロトコルで、バージョンアップが頻繁に行われる可能性があります。

そのため、古いMCPサーバーと最新のホストのバージョンが合わないことがあるんですね。

対策としては「サーバーとホストを同じタイミングで更新し、互換性を保つ」ことが基本。

コミュニティサーバーの場合はメンテが止まっていることもあるので、そこにIssueを挙げたり、フォークして自分で修正するケースも珍しくありません。

運用ポリシーと人間の介在

便利な仕組みほど人間側のルール作りが大切になります。

特に、自動化による作業効率アップの反面、「どこまで機械に任せるのか?」があいまいだとトラブルを招きやすいんですよね。

こうした運用ポリシーをちゃんと決めておくと、「MCPのおかげでめっちゃ楽になったけど、そこかしこで問題発生…」という最悪のパターンを防げます。

AIを使いこなす=テクノロジーと人間の責任分担を上手に設計することだと僕は思っています。

AIのルール設定(プロンプト管理)の難しさ

もう一つ見落とされがちなのが、AIの指示(プロンプト)次第で全然違う動きをするという点。

MCPがあればAIは各種ツールを使えるわけですが、「どんな状況でどういう挙動をするか」をプロンプトである程度コントロールしないと、想定外の連携が発動する可能性があります。

- プロンプトに制約を書く

例えば「顧客データベースから個人情報を引き出す際は要約に含めないこと」や「Slack投稿は定型フォーマットで行うこと」など。

AIが混乱しないよう、明示的な制約をプロンプトに盛り込みましょう。 - 高度なエージェント構築では“ルールベース”も導入

自由度の高い自律エージェントを目指す場合、LLMのプロンプトだけでは不十分になることがあります。

その際は状態管理や決定フローを持つプログラム(例:LangChainや自身のルールエンジン)を組み合わせて、AIの動きを制御するケースが増えています。

MCPはあくまでツール接続の部分なので、AIの思考プロセス管理はまた別の工夫が必要となるんですよね。 - テストプロンプトを複数用意して検証

実稼働前に、いくつかのシナリオを想定し、AIが正しい動きをするかをテストします。

「ファイル検索依頼→ダミーファイルリストを返す」「保存不可のフォルダに書き込みを試す」などのケースでどう動くかを検証し、問題があれば修正する流れです。

こうしたプロンプト管理と運用ポリシーをしっかり固めれば、MCPはとても強力な武器になります。

逆に、そこを雑にしてしまうと「AIが思いもよらない連携をやらかした…!」ということが起こりかねないので、気を付けたいところですね。

MCPの今後と環境づくり

さあ、ここまででMCPの導入メリットや注意点、運用ポイントなどをお話ししてきました。

最後に、MCPが今後どんな展開を迎えそうか、そしてどういう環境を整えればいいのかという視点を掘り下げましょう。

僕としては、これからの数年でMCPの存在感はますます高まり、AI活用の当たり前インフラになっていく気がしています。

MCPが選ばれる理由の再整理

ここで、MCPが選ばれる理由をおさらいしておきましょう。

- 標準プロトコルでスケーラブル

企業がAIを導入する際、カスタム連携のコストや運用の煩雑さがネックになりがちでした。

MCPによってそこが劇的にシンプル化するので、開発者やIT部門にとっては非常に魅力的です。 - オープンソースコミュニティの活況

MCPサーバーのリファレンス実装やサンプルがGitHubにどんどん増えていて、開発者同士の交流が盛ん。

これにより、新しいツールとの連携がすぐに追加される可能性が高いです。 - Anthropicだけでなく他社AIにも波及する可能性

現状、Claude Desktopや一部IDE拡張などがメインのホストですが、OpenAI系やGoogle系のモデルも将来的には同等の標準を取り入れるかもしれません。

そうなれば、MCPを軸に“どのAIでも統一的にツール接続”できる世界が本格的に来るでしょう。

企業導入事例の広がり

一部では既に大手企業やスタートアップがMCPを本格利用しています。

たとえばSlackやGitHubを扱う開発組織にとっては、「コードとドキュメントを一箇所で管理できるAIアシスタント」を作りやすいわけですから、試す価値が大いにある。

また、非エンジニア系の現場でも、Google Driveや各種SaaSの操作をAIに任せるシナリオが増えています。

- マーケティング部門

Driveの資料とSNS管理ツールを連携し、AIがキャンペーン施策をまとめてくれる。 - 人事部門

従業員データベースや面接フィードバックをAIが自動集計する。 - 営業チーム

Slackやメール連携で顧客情報を管理し、AIが契約更新のリマインドを送る。

こういった使い方を見ると、業種や職種を問わず「なんでもAIに手伝ってもらえる」時代になってきたなと感じます。

MCPが普及するほど、そのハードルはどんどん下がり、より多くの人が手軽にAIエージェントを活用できるようになるでしょう。

対応ツールの拡大とマーケットプレイス構想

今後は、MCPの「サーバー(プラグイン)」を手軽に探してインストールできるマーケットプレイスが登場するかもしれません。

すでにコミュニティの有志が、MCPサーバーの一覧ページや検索機能を立ち上げる動きがあるようで、まるでスマホアプリストアのように「ツール追加」ができる未来が近づいています。

- 標準的なUI

たとえばClaude Desktopや他のAIクライアントで、GUI上から「このMCPサーバーを追加する」とワンクリックで導入できる仕組み。 - 評価やレビュー

「このサーバーは安定性が高い」「こっちは機能が豊富だけどバグが多い」といったレビューを見ながら選べるようになれば、利用者も安心です。 - 有償サーバーの提供

将来的には有償で高機能・高サポートのMCPサーバーを提供するSaaS企業が出る可能性もあるでしょう。

企業向けにセキュリティ・監査・SLA保証をセットにして販売、みたいなビジネスモデルです。

このように、“AIに使わせるツールの流通”が活性化すると、ますますAIが便利に使われるようになりますよね。

そのうち誰かが「MCP版スマート家電連携サーバー」を作って、AIが家の照明やエアコンを操作する時代が来るかもしれません!

エンタープライズ対応の進化

企業利用の観点でいえば、認証統合(SSO)やActive Directory連携、監査ログ、クラスタリングなどが今後求められるでしょう。

すでに一部のMCPサーバー実装ではSAML/OAuth2.0連携を実験的にサポートしていて、社内システムとのSSOを実現している例があります。

さらに、クラウド環境での水平スケーリングに対応するにはサーバーのステートレス化やロードバランサー活用が必要になり、そこを拡張していく動きが加速するはず。

MCP自体はオープンな仕様なので、企業が独自に拡張することもできます。

例えば

- MCPコマンドに追加フィールドを持たせて権限レベルを指定する。

- 社内PKI証明書による安全な通信路を使う。

など、組織が必要とするセキュリティ要求に合わせてカスタマイズ可能です。

ゆくゆくは正式に“エンタープライズ拡張”みたいな仕様が策定されるかもしれません。

AIエージェント同士の連携

僕が個人的にワクワクしているのが、MCPを使ったAIエージェント同士の連携です。

例えば、あるエージェントがSlackの情報をまとめ、別のエージェントがそれをGitHubのIssue化して、さらに別エージェントがDBにログを取る…というエージェント間パイプラインが成立すれば、人間が手を動かさなくてもどんどん処理が進みます。

- エージェントA

「Slack監視担当、メッセージ要約と行動指示を生成」 - エージェントB

「GitHub管理担当、Issue作成やPull Request管理を実行」 - エージェントC

「DBにログ保存、日次集計、結果を再度Slackへレポート」

これらがMCPを共通言語として「ツールを使う役割」を分担し、相互に連携していくイメージですね。

まだまだ研究中の領域ですが、将来的には“自律分散AIエコシステム”が実現する可能性が大いにあります。

僕自身は「複数AIが協力して業務を最適化してくれる」世界を夢見ているので、これからの進化が楽しみでなりません。

未来に向けた準備

MCPはまだ新しい技術ですが、標準プロトコルとしての可能性は大きいと感じます。

今からできる準備としては、まずは小規模なPoC(概念実証)を試してみることをおすすめします。

- 少人数チームでDriveやSlack連携を導入

実際に使ってみて「どんな作業が楽になるか」「どこにリスクがあるか」を掴みましょう。 - 社内のテスト環境やローカル環境でMCPサーバーを動かす

大きなデータや機密情報ではなく、サンプルデータでお試し運用して問題が起きないか確認するのも大事です。 - 運用ルールやアクセス権限のテンプレートを作る

小さなチームでうまく機能したら、これをベースに全社展開する際のガイドラインに活かす流れですね。

こうしたステップを踏みつつ、コミュニティや公式リポジトリの動向をウォッチしておくと、MCPに関するトラブルシューティングや新機能のキャッチアップもスムーズになります。

大規模に使う前にまずスモールスタートするのは、どんな新技術でも鉄板パターンですね。

まとめ

- MCP(Model Context Protocol)は、AIエージェントと外部サービス・データをシームレスにつなぐための新しい標準プロトコルです。

- 従来のように個別APIやプラグインを作り込まなくても、一度MCPサーバーを用意すれば複数のAIホストから同じ手順でアクセスできるようになります。

- 開発効率・保守性が上がり、セキュリティや権限管理も標準化されているため、複数ツールの並行利用や業務フロー自動化がぐっとやりやすくなるのが魅力です。

- 一方で、AIによる誤操作や情報漏洩を防ぐためのルール整備やアクセス制御、適切な承認フローなどが必須。運用ポリシーをしっかり設計して、人間がきちんと監督すれば安全かつ生産性を大幅に高められます。

- 現状すでにGoogle Drive、Slack、GitHub、DB連携など多くのMCPサーバーが公開され、コミュニティも活発。これから対応ツールはさらに増え、企業システムやクラウドサービスとの統合も進展していく見通しです。

- 最終的には、MCPを介してAIエージェントが社内外のリソースを自在に活用し、業務や生活を大幅に効率化する世界が見えてきます。エンタープライズ機能やマーケットプレイスの充実など、今後の進化にも要注目です。

MCPは、まさしく「AIとツールを結ぶ革命的なインフラ」として誕生しました。

僕自身も初めて触れたとき、「これこそAIエージェント時代を本気で切り開く鍵だ!」と感じたものです。

もしあなたが「AIを活用したいけど、外部ツール連携がネックになっている…」とお悩みなら、ぜひMCPを検討してみてください。

少し導入に手間はかかるかもしれませんが、一度仕組みを作れば驚くほど楽になるし、チーム全体が“AIが当然いる”世界へ踏み出せるはずです。

これからのAIエージェント活用の根幹を支えるMCPを、あなたもぜひ体験してみてください!